昆仑万维开源 2 千亿稀疏大模型 Skywork-MoE,引领技术新潮流

6 月 3 日消息,昆仑万维()今日宣布开源 2 千亿稀疏大模型 -MoE,基于之前昆仑万维开源的 -13B 模型中间 扩展而来,号称是首个完整将 MoE 技术应用并落地的开源千亿 MoE 大模型,也是首个支持用单台 RTX 4090 服务器(8 张 RTX 4090 显卡)推理的开源千亿 MoE 大模型。

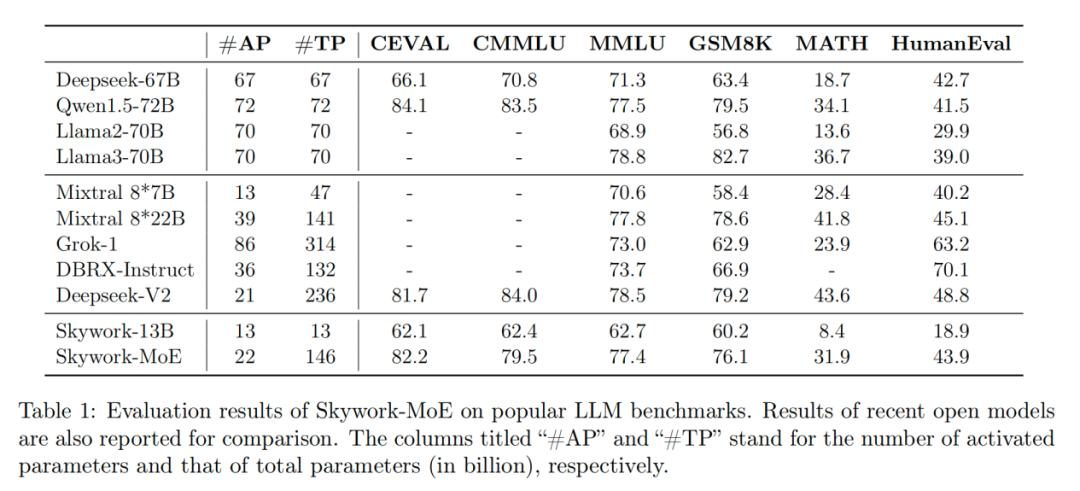

据介绍,本次开源的 -MoE 模型隶属于天工 3.0 的研发模型系列,是其中的中档大小模型(-MoE-),模型的总参数量为 146B,激活参数量 22B,共有 16 个 ,每个 大小为 13B,每次激活其中的 2 个 。

天工 3.0 还训练了 75B (-MoE-Small) 和 400B (-MoE-Large)两档 MoE 模型,并不在此次开源之列。

根据官方测试,在相同的激活参数量 20B(推理计算量)下,-MoE 能力接近 70B 的 Dense 模型,使得模型的推理成本有近 3 倍的下降。同时 -MoE 的总参数大小比 的总参数大小要小 1/3,用更小的参数规模做到了相近的能力。