穆拉蒂发布最新多模态大模型GPT-4o

的新品终于官宣,是一个“全能助手”。

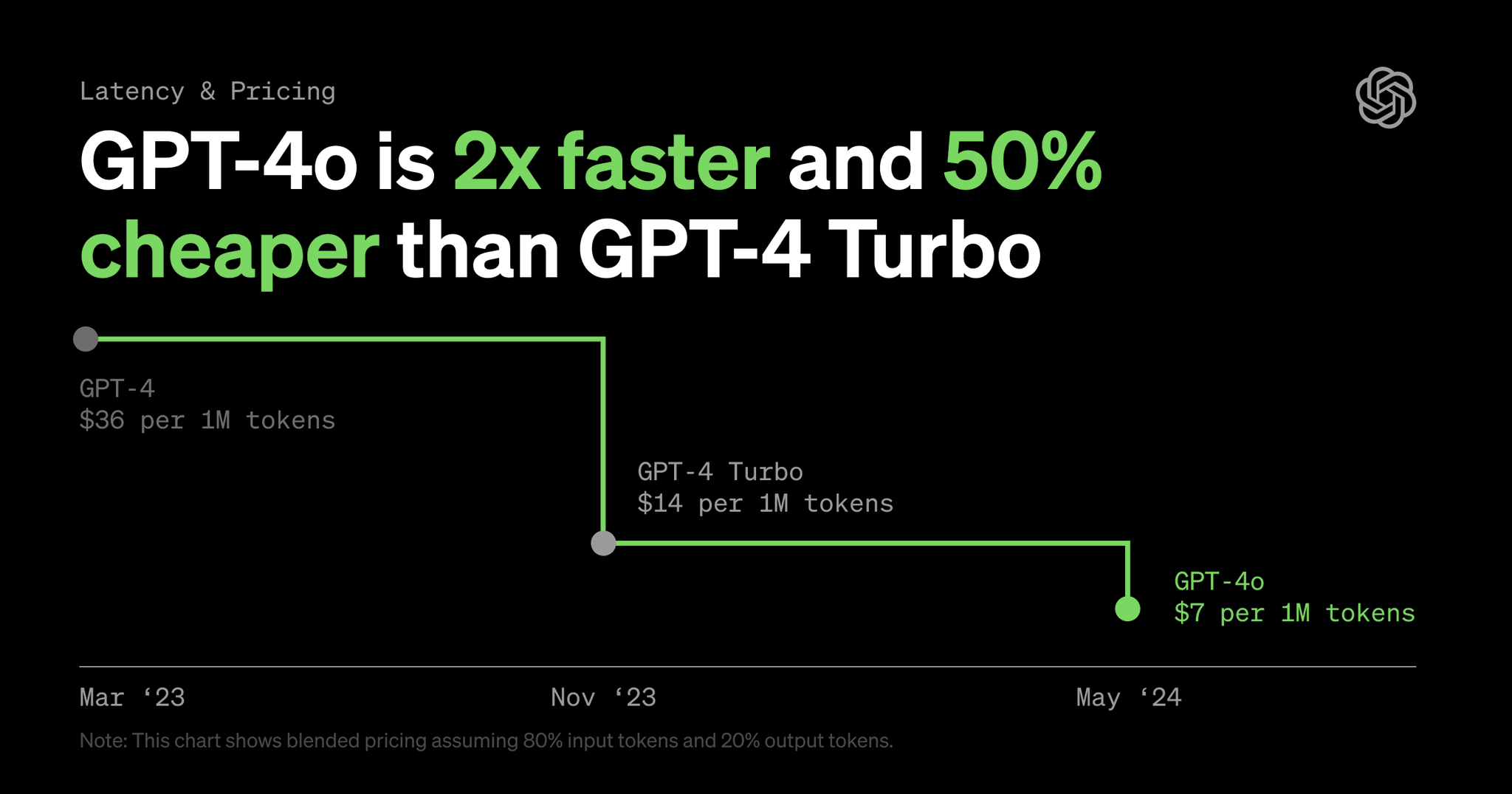

北京时间5月14日凌晨,发布最新多模态大模型GPT-4o(o代表omini,全能),支持文本、音频和图像的任意组合输入,并生成文本、音频和图像的任意组合输出。文本、推理和编码智能方面性能达到了GPT-4 Turbo水平,同时在多语言、音频和视觉能力方面也达到新高。据介绍,GPT-4o的速度比GPT-4 Turbo快2倍,速率限制提高5倍,最高可达每分钟1000万token,而价格则便宜了一半。

首席技术官米拉·穆拉蒂(Muri )在发布会上表示:“通过语音、文本和视觉进行推理非常重要,因为我们正在研究与机器交互的未来。”

官网显示,GPT-4o的文本和图像功能将在更新后提供给所有用户,Plus用户的消息数量使用上限是免费版的5倍(使用上限后会切换回GPT-3.5版本)。而新版语音模式将在未来几周向Plus用户推出,同时也将会在API(应用接口)中向小范围推出对GPT-4o的新音频和视频功能的支持。

穆拉蒂在春季更新发布会上介绍GPT-4o

在发布会现场演示中,GPT-4o可以像人工智能助手一样,实现用户与的实时交互,不再是一问一答,也不需要其他按键操作。

比如,用户可以说“Hi,”并提出问题,也可以在回答时打断它,它还可以识别用户声音中展现的情感,甚至实时根据用户的需求来使用不同情感风格的声音。

据介绍,GPT-4o的音频输入平均反应时间为0.32秒,与人类对话中的反应时间相似。

表示,在GPT-4o之前,使用语音模式与对话的平均延迟时间为2.8秒(GPT-3.5)和5.4秒(GPT-4)。此前的语音模式由三个独立模型组成:一个简单模型将音频转为文本,GPT-4接收文本并输出文本,第三个简单模型将文本转回音频。这个过程也让主要的智能源GPT-4丢失了很多信息,比如不能直接观察音调、多人讲话或背景噪音,也不能输出笑声、歌声或表达情感。而GPT-4o通过在文本、视觉和音频方面训练了一个端到端新模型,所有输入和输出都由同一个神经网络处理。

不过,也坦言,由于GPT-4o是公司首个结合了所有前述模式的模型,因此在探索模型功能及其局限性方面仍处于起步阶段,GPT-4o也开始扩大红队(测试)的访问权限。

此外,GPT-4o还提高了的视觉能力。在现场演示中,通过手机实时拍摄的视频或电脑桌面屏幕上的截图,可以快速回答相关问题,帮助解决计算、编程等问题。

演示中还出现了一段小插曲。因为“幻觉”问题,在还没打开摄像头看到画面时就表示理解了,在演示者提示后,她说“哎呀,我太兴奋了”,随后实时指导完成了一道数学题。

同时,还在X(推特)上实时搜集到网友的反馈,进行了的情绪分析演示。通过演示者的实时摄像头画面,对表情中的开心、兴奋等情绪做出了分析。

GPT-4o的英语和代码文本性能与GPT-4 Turbo相当,在非英语语言文本方面也有显著提高,能支持50种语言。发布会上,穆拉蒂演示了让全新充当只会意大利语与只会英语的两人的翻译,实现了跨语种交流的无缝衔接。

GPT-4o速度比GPT-4 Turbo快2倍,价格则便宜了一半

发布会上,还发布了电脑桌面版和新UI界面。根据官方公告,目前仅适用于macOS,版将在今年晚些时候推出。

“我们知道这些模型越来越复杂,但我们希望交互体验变得更加自然、轻松,并且让你根本不关注用户界面,而是专注于与GPT(交互)。”穆拉蒂表示。

CEO山姆·奥特曼(Sam )也表示:“对我来说,与电脑交谈从来没有真正自然过,而现在却很自然……我真的看到了一个令人兴奋的未来,我们可以用电脑做比以往更多的事情。”

“AI达到人类级别的响应时间和表现力是一个很大的改变,给人的感觉就像电影中的人工智能,而它的真实性仍然让我感到有些惊讶。”他表示,“最初的展示了语言界面的雏形,而这款新模型给人的感觉却截然不同,它快速、智能、有趣、自然而且乐于助人。”

奥特曼还发文“her”,或许也表达了他对GPT-4o的评价以及对未来的畅想(在电影《Her》中,人工智能助手主动给男主人公打了电话,告知他一些事情)。

山姆·奥特曼的推文

奥特曼表示,的一项重要使命就是免费(或以优惠价格)向人们提供功能强大的人工智能工具,“我感到非常自豪的是,我们在中免费提供了世界上最好的模型,并且没有广告或类似的东西”。

他表示:“我们是一家企业,会找到很多可以收费的东西,这将帮助我们为数十亿人提供免费、出色的人工智能服务(希望如此)。”

此前,据外媒报道,苹果公司已接近与达成协议,今年将后者的部分技术引入,提供由支持的“聊天机器人”作为iOS 18中人工智能功能的一部分。

不过,苹果同时还与谷歌就授权聊天机器人进行了谈判。而谷歌将在此次春季更新发布会之后一天举行I/O开发者大会,谷歌在大会的官方博文中曾提到“ 时代”,预计将会发布大模型的最新动态。