AI大模型“神仙打架”发布日均处理1200亿

每经记者 王紫薇每经编辑 程鹏 杨夏

48小时内,国内外大模型“神仙打架”。

在北京时间15日凌晨1点召开了长达2个小时的年度I/O开发者大会,大会围绕AI大模型产品与服务,现场提及AI的次数超过了120次;在前一天的凌晨,“力压”一天先开了一场“科技春晚”,免费的、“人类级别响应”的GPT-4o被推出。

而在15日下午,字节跳动终于对外发布了自己的大模型产品家族,包含豆包通用模型Pro、豆包通用模型Lite两个通用模型以及7个细分领域模型。

据此次会议透露,豆包系列的一些产品已经默默上架了近一年,并且在用户量上取得了不错的成绩。火山引擎总裁谭待同时在会上介绍,豆包大模型目前日均处理1200亿文本,生成3000万张图片。

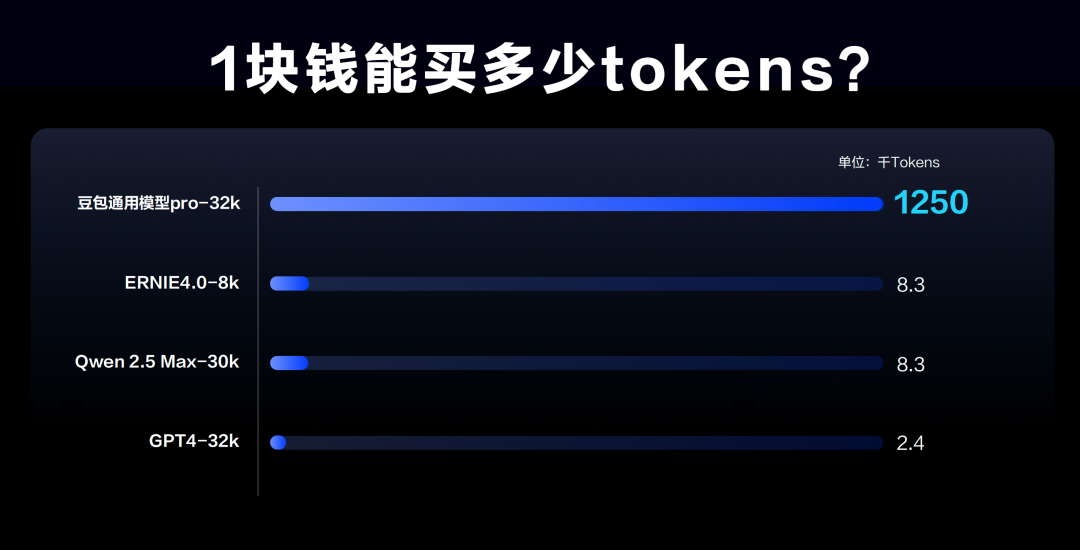

此次火山引擎带着一系列模型亮相,显然在大模型这条路上是要大干一番。杀手锏之一就是率先开卷价格战:火山引擎总裁谭待在会上举例表示,豆包主力模型的定价比行业便宜了99.3%。

对于击穿行业的定价,火山引擎相关负责人回应《每日经济新闻》记者,此次定价与Open AI发布的免费使用的GPT-4o没有关系:“豆包模型家族里目前没有对标GPT-4o的同类型模型。”

“大的使用量,才能打磨出好模型,也能大幅降低模型推理的单位成本。”谭待在会上这样解释定价策略。行业人士则告诉《每日经济新闻》记者,火山引擎在发布大模型的时间上比同行要慢了半年左右。低价策略,也是火山引擎招揽大模型客户的方式之一。

豆包大模型击穿行业低价

豆包大模型,原本是字节的“云雀”大模型。在大模型之前,豆包App更被人熟知。字节跳动产品与战略副总裁朱骏在会上分享表示,豆包App去年已是字节重点投入的方向。

豆包App基于豆包大模型打造而来,朱俊透露,在苹果和各大安卓应用市场,豆包APP的下载量在AIGC类应用中排名第一。豆包上已有超过800万个智能体被创建,月度活跃用户达到2600万。

同样基于豆包大模型模型打造的,还有AI应用开发平台“扣子”、互动娱乐应用“猫箱”,以及星绘、即梦等AI创作工具。据火山引擎总裁谭待介绍,经过一年时间的迭代和市场验证,豆包大模型正成为国内使用量最大、应用场景最丰富的大模型之一,目前日均处理1200亿文本,生成3000万张图片。

谭待在会上表示,降低成本是推动大模型快进到“价值创造阶段”的一个关键因素。

目前市面上主要的32k主力模型中,GPT4的价格是每千毛2分,百度的文心一言是1毛2分每千Token,阿里最新的千问2.5Max价格也是1毛2分每千Token。

在自然语言处理(NLP)中,token是指文本中最小的语义单元。记者了解到,按已有惯例,1个token≈1—1.8个汉字,而在英文文本中,1个token≈3—4个字母。而在商业领域,千是大模型主要计费单元。

从国内外模型价格的对比来看,国内大模型的价格比GPT-4已经便宜了70%。而豆包Pro 32k模型的定价是0.0008元/千,比行业价格直接降低了99.3%。豆包Pro 128k模型,定价为是0.0005元/千,与行业内相比降低了95.8%。

这是什么概念?

举个例子:《三国演义》75万字的文字量级,可以在火山引擎花1块钱可以处理3本,1.5块钱可以把《哈利波特》中文版8本书(274万字)处理完还有剩余。而对于个人用户来说,200万的汉字处理量,不出意外,几乎可以用到退休。

在会后,谭待接受采访时谈为什么选择“卷价格”,他表示:“第一,我们能够做到;第二,市场需要。”他表示,从市场层面来看,目前对大模型的训练需求越来越多。但企业来在AI转型上充满不太不确定性,试错成本需要尽量低,而火山引擎的技术可行。

他同时强调,不是为了卷价格而卷,火山引擎不做亏本的事情,“非技术手段(的卷价格)是没有办法长期持续的”。

就在5月14日凌晨,最新发布的GPT-4o也放开了限制,功能全部免费提供给所有用户使用。而市场分析指出,免费的另一含义,是将加大模型推向市场的力度。

行业人士告诉《每日经济新闻》记者,他认为卷价格也是火山引擎在抢客户的方式之一。在去年一整年“百模大战”的时候,字节几乎没有对外官宣过任何模型,当时的字节没有跟进这股浪潮。此次带着9个模型而来,字节显然要在这个大模型时代分一杯羹。

云服务领域资深人士、商业伙伴网全媒体总编李卫忠对此也告诉《每日经济新闻》记者:“(字节)每次都是看准市场已证明的成功商业模式,集中力量后发硬刚。”

分羹数字化转型大市场 发力全栈AI解决方案

除了引人注目的大模型家族外,此次发布会火山引擎的发布内容,其实是自身的“全栈的AI解决方案”。

整体的产品发布分为三层:首先是发布会最为核心的模型层面的豆包模型家族,以及火山引擎的托管服务火山方舟2.0平台;第二层是各类AI应用产品,比如营销层面的产品智能创作云2.0版本、智能数据洞察产品的全新AI助手;还有云基础服务层面的产品,比如大规模AI场景的混合云产品智算版。

从产品名称上看,AI应用产品与云基础服务层面的产品都是迭代版,大模型是首次发布。而作为字节跳动旗下的云服务部门,火山引擎此次发布会之后透露出的意味,更像是AWS之于亚马逊的定位。

会后,谭待在回答此次发布对火山引擎有着怎样意义的问题时表示,AI本身就是驱动下一步很重要的力量。

“对一个完整的产品来说,肯定需要大模型这块的服务,我们一年前就推出MaaS(模型即服务)服务,只不过那时候是三方模型,没有字节的模型,字节豆包模型加入模型矩阵里面去,肯定让我们在整个AI领域更强。”谭待说。

谭待在会后采访中表示,目前的火山引擎的生态包括了IaaS(基础设施即服务)、PaaS(平台即服务)、SaaS(软件即服务)。他认为,在服务企业数字化转型的过程中,AI的到来其实把数字化同时往深、往广推进了。

“我觉得AI其实建立了一个算力到智能的相关性,实际上是能够把越来越多的数字化的需求和生活工作中场景和算力融合。对火山引擎来说,我们的愿景就是,通过领先的云和智能技术,帮助企业降本增效和加速创新。”谭待表示。

被问及国外大模型对比时,谭待表示,豆包大模型与()、、等模型存在差距。

他同时表示:“我们的模型在不断进化,一旦进化到某一个层次的时候,在这个上面做应用就有可能性了。第二,虽然有差距,但是我们追的速度还是可以的。包括我们的豆包的原生应用和体验越来越好,用户量也越来越大。所以我觉得本身我们追赶的速度比较快,所以我觉得这是比较重要的。”

谭待同时表示,目前Maas层面上的竞争远远谈不上激烈。他表示,受限于模型的效果、推理成本和落地难度,大模型的应用其实没有真正铺开。

“价格做下来应该就是一个机会,这个过程中我觉得火山最重要的是和大家一起怎么把最佳实践做好,把这个市场做大,我觉得这是最关键的事情。”谭待说。

《每日经济新闻》记者在会后注册了豆包,并使用它来搜索此次火山引擎的发布会。

豆包这样评价道:“字节跳动自研大模型的发布是其在人工智能领域的重要举措,展示了其技术实力和创新能力。通过与智能终端厂商的合作,字节跳动有望推动大模型在更多领域的应用和发展。然而,对于大模型的评价还需要考虑其性能、准确性、安全性等多个方面,同时也需要关注其在实际应用中的效果和影响。”

(文中图片均为火山引擎供图)

记者|王紫薇

编辑|程鹏杨夏杜恒峰

校对|何小桃

|每日经济新闻 原创文章|

未经许可禁止转载、摘编、复制及镜像等使用