又一家国内大模型官宣大幅降价

又一家国内大模型官宣大幅降价。

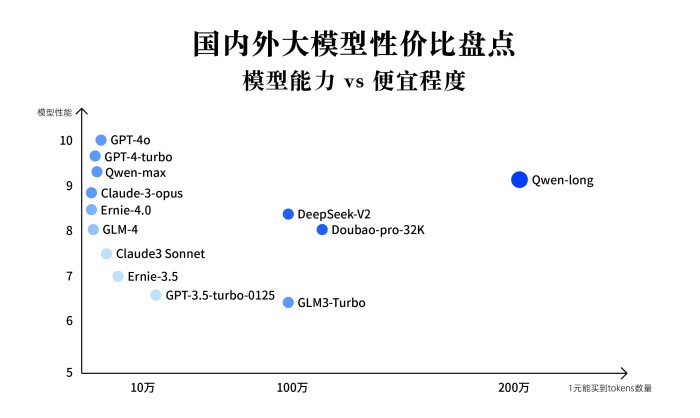

5月21日,阿里云在武汉AI智领者峰会上宣布,旗下9款通义商业化及开源系列模型大幅降价。其中,通义千问GPT-4级主力模型Qwen-Long,API输入价格从0.02元/千降至0.0005元/千,直降97%。这意味着,1块钱可以买200万,相当于5本《新华字典》的文字量。这款模型最高支持1千万长文本输入,降价后约为GPT-4价格的1/400。同时,Qwen-Long输出价格也直降90%至0.002元/千。

另外,在权威基准上性能追平GPT-4-turbo的Qwen-max,API输入价格从0.12/千降至0.04元/千,降幅67%。在开源模型方面,Qwen1.5-72B的API输入价格从0.02元/千降至0.005元/千,降幅75%;API输出价格从0.02元/千降至0.01元/千,降幅50%。

5月以来,国内已经有多个大模型下调了价格。其中,于5月6日率先把旗下的大模型-V2把每百万的输入价格降低至1元,这款模型能力对标GPT-4 ,但价格只有GPT-4的1%。随后,智谱和豆包等多个大模型也相继大幅下调了多款模型的价格。

就在通义千问宣布大幅降价之后,百度也紧跟宣布文心大模型的两款ENIRE Speed、ENIRE Lite免费使用,并即刻生效。虽然这两款模型属于轻量级模型,和通义千问等GPT-4级主力模型不在一个量级,但全部免费使用还是增加了大模型价格战的火药味。

很多人对移动互联网时代的价格战并不陌生,对C端用户来说,低价被视为吸引用户、扩大市场份额的有效手段。但此前,B端产品很少出现像大模型一样厂商集体把价格降低一个数量级的情况。

国产大模型集体大幅降价可谓开启了一个新的竞争阶段,也将加速“百模大战”的进程。

大模型到了以价格换市场的阶段

实际上,不只是国产大模型在集体降价,也在不断下调大模型价格。

从2023年年初以来,已经进行了4次降价。其中,在5月14日发布的GPT-4o,在处理速度上提升了高达200%,同时在价格上也实现了50%的下降。按照的预期,大模型的价格将会以每年50-75%的幅度继续降低。

只不过,国产大模型的降价来得更猛烈。阿里云智能集团资深副总裁、公共云事业部总裁刘伟光在演讲中表示,阿里云这次大幅降低大模型推理价格,希望加速AI应用的爆发。

阿里云方面公布的最新数据显示,通义大模型通过阿里云服务企业超过9万、通过钉钉服务企业超过220万,已在PC、手机、汽车、航空、天文、矿业、教育、医疗、餐饮、游戏、文旅等领域落地应用。

横向对比来看,通义大模型在行业客户中的受欢迎程度较高。但纵向来看大模型应用在各个行业中的市场份额,还将有较大的发展空间。数据显示,截至今年3月,基于大模型的AIGC行业用户量为7380万,尽管同比增长了8倍,也仅占移动互联网用户量的6%。

一位大模型行业从业者对界面新闻表示,此前价格确实是制约大模型更广泛落地的重要因素之一。尤其是中小企业,他们对公司运营成本非常敏感,在和大模型公司洽谈合作时也会核算成本,而核算的结果经常是使用大模型并不划算。

上述从业者还指出,制造业等传统行业本身对大模型的认知程度不高,大模型在这些行业落地过程中面临很大的教育成本,再加上大模型本身的使用成本高,这些都让大模型在传统行业落地面临一些困难。

大幅降价之后,大模型因为成本问题面临的落地难题将被很大程度上解决,这也有助于其在更多行业和应用场景中落地。按照刘伟光的预计,未来大模型API的调用量会有成千上万倍的增长。

落地应用想象空间巨大但国内大模型领域的竞争更加激烈,这让国产大模型在以价格换市场的路上步子迈得更大。从整体的行业竞争来看,接下来各个大模型公司之间更为激烈的价格竞争已不可避免。

尤其在降本增效的背景下,企业客户选择大模型时也会更加注重成本和收益。拥有价格优势的大模型也将会快速跑马圈地,形成头部效应,一些价格优势小、规模比较小平台的市场空间将会被挤压。

国产大模型靠什么大幅降价?

影响大模型推理价格的降低的因素有很多,技术能力、训练成本、规模效应都是重要的影响因素。

即使多个国产大模型的价格都在大幅降低,但各家在同等量级的大模型价格上还是有一些差异。比如,在GPT-4级的模型中,通义千问Qwen-Long 0.0005元/千的输入价格已经是击穿全球底价。

从整体的价格对比上来看,依托于云计算平台的大模型价格比创业公司的大模型价格更具有优势,这得益于公共云的技术红利和规模效应,带来的巨大成本和性能优势。

云计算本身就是一个具备网络效应和规模效应的商业模式。尤其是公有云,用的客户越多,供应链采购成本、均摊研发成本和资源闲置成本就能不断降低,产品价格也会越便宜。

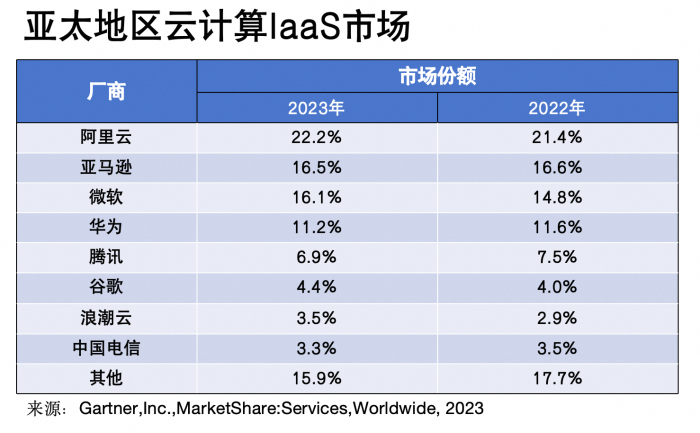

在公有云市场中,阿里云已经多年蝉联市场份额第一。国际咨询机构发布最新云计算市场追踪数据报告显示,2023年,其在亚太地区云计算IaaS市场排名第一,市场份额为22.2%,比去年的21.4%有一定涨幅。

在规模化能力的支撑下,阿里云云产品价格也在持续下降。继去年4月的“史上最大规模降价”后,阿里云今年再次开启更大力度的降价:100多款产品、500多个产品规格的官网价格平均降低20%,最高降幅55%,核心产品价格几近全网最低价。阿里云成本大幅下降让通义千问的训练成本和推理成本也大幅下降。

同时,阿里云从模型和AI基础设施两个层面不断优化,追求极致的推理成本和性能。比如,基于自研的异构芯片互联、高性能网络HPN7.0、高性能存储CPFS、人工智能平台PAI等核心技术和产品,构建了极致弹性的AI算力调度系统,结合百炼分布式推理加速引擎,大幅压缩了模型推理成本,并加快模型推理速度。

比如,PAI支持10万卡量级的集群可扩展规模,超大规模训练线性拓展效率达96%。在大模型训练任务中,达到同样效果可节省超50%算力资源,性能达到全球领先水平。

当前,有非常多的应用场景对推理提出了更高要求。随着模型尺寸和上下文长度不断增大,应用场景逐渐多样,推理资源的规模正变得越来越大、场景复杂度越来越高,模型的推理效果、性能和成本就成了一个“不可能三角”,很难都达到最优。

针对这个“不可能三角”,阿里云通过高性能优化、自适应调优以及可扩展部署来保证大模型推理的效果好、性能优、成本低。尤其是通过可扩展部署,模型推理部署资源的扩展和弹性,解决推理服务在一定时期内的潮汐现象,降低成本。

此前,阿里云对外传递的信号是,随着技术红利和规模效应的不断释放,还会持续降价,这也意味着大模型的低价竞争才刚刚开始。

公共云+API将成为企业使用大模型的主流方式

多家机构预测,大模型应用爆发在即。

海通国际研报指出,2024年有望成为国产大模型全面商业落地的元年,先进的大模型能力也将逐渐转化为落地实际场景的产品应用,从而带动大模型在金融、教育、法律、医疗等众多垂直行业的持续落地,AI2B与AI2C的需求天花板也有望全面打开。

国际知名咨询机构IDC预测,2024年全球将涌现出超过5亿个新应用,这相当于过去40年间出现的应用数总和,智能化应用将呈现爆发式增长,大模型的未来发展将趋向于通用化与专业化并行。

从过去一年各个领域的企业落地应用大模型的实践来看,企业面临的难题除了成本之外,还包括开发门槛、数据安全等诸多问题。比如,金融、医疗等领域企业对数据安全的要求较高,出现数据安全问题的损失非常大,所以在大模型应用过程中探索中较为谨慎;还有一些领域的企业技术能力偏弱,他们迫切需要更低门槛的开发方式。

总结过往的实践,刘伟光认为,不管是开源模型还是商业化模型,公共云+API将成为企业使用大模型的主流方式。

一方面,公共云的技术红利和规模效应,带来巨大的成本和性能优势。即便是同样的开源模型,在公共云上的调用价格也远远低于私有化部署。以使用Qwen-72B开源模型、每月1亿用量为例,在阿里云百炼上直接调用API每月仅需600元,私有化部署的成本平均每月超1万元。

另一方面,云上更方便进行多模型调用,并提供企业级的数据安全保障。目前,阿里云已主导或深度参与10多项大模型安全相关国际国内技术标准的制定,可以为每个企业提供专属VPC环境,做到计算隔离、存储隔离、网络隔离、数据加密,充分保障数据安全,解决企业在数据安全上的顾虑。

同时,云厂商天然的开放性,能为开发者提供最丰富的模型和工具链。阿里云百炼平台上汇聚通义、百川、、Llama系列等上百款国内外优质模型,内置大模型定制与应用开发工具链,开发者可以便捷地测试比较不同模型,开发专属大模型,并轻松搭建RAG等应用。从选模型、调模型、搭应用到对外服务,一站式搞定,降低开发难度。

从大模型的落地应用实践来看,这个趋势不只在中国适用,在美国同样适用:美国每一家大模型公司都深度绑定了一家云计算公司。比如,和微软Azure深度绑定,而和亚马逊AWS深度绑定。

公共云+API的模式,本质上就是让企业以更低成本和门槛使用大模型能力。这个模式也是支撑一些大模型能够持续打价格战的关键。

可以预见,价格战打到最后,受益的只是少数几家头部企业,而背后没有绑定大型云计算平台的大模型公司,面临的将是又是一轮行业洗牌。