中国智能算力够用吗?市场供给情况成关键因素

中国的智能算力到底够不够用,需要从诸多现实情况衡量,一个确定的信息是,用好闲置算力是必须做的事

中国的智能算力够不够用?这是近两年中国算力产业发展过程中的重要问题。

智能算力需要AI(人工智能)芯片。2023年,算力短缺是业界共识;2024年,算力短缺和过剩两种矛盾的声音同时存在。回答上述问题,首先要确定有多少市场供给。

我们通过多位供应链人士了解到,按保守计算,2024年中国市场英伟达H20系列芯片出货量约为70万枚,某国产主流AI芯片出货量约为30万枚。

一种更乐观的预期来自国际市场调研机构,该机构今年7月预估,2024年中国市场英伟达H20系列芯片出货量预计超过100万枚。按一枚H20芯片价格约1.2万美元算,它将为英伟达带来超过120亿美元收入(按美元、人民币汇率1∶7.1计算,约合854亿元人民币)。同期,中国市场某国产主流AI芯片出货量预计约为55万枚。但多位供应链人士认为,预估出货量偏乐观,高于实际情况。

目前中国市场AI芯片主要来自英伟达和华为。除此之外,少数科技公司、创业公司也在自研AI芯片,部分经销商还在通过多种渠道采购英伟达AI芯片。

也就是说,2024年中国市场先进AI芯片(可同时用于大模型训练和推理的AI芯片。如英伟达的A100/A800、H100/H800、B100、H20等,华为昇腾910系列)出货量在100万枚以上。只看绝对数量,这个规模并不小。那么,算力究竟是短缺还是过剩?

我们从多个科技云厂商、部分电信运营商人士处了解到,“短期够用,长期短缺”是他们的共同判断。短期来看,现有智能算力能满足基本业务需求,局部甚至存在过剩现象。但长期来看,AI应用落地需要更多算力。因此,各家采取了“适度超前投资”的策略,仍在大规模采购算力。

一位科技企业战略规划人士的观点是,目前算力市场供需总体平衡,但局部不均。大型科技公司(华为、阿里、字节跳动、腾讯、百度等)、电信运营商(中国移动、中国电信、中国联通)即使算力够用,也会坚持超前投资。2023年跟风囤芯片的中小服务商正在降价出售闲置算力,这里出现了“局部过剩”。

谁在投资算力?

中国市场上,目前在大规模采购智能算力的主力军是大型科技公司(华为、阿里、字节跳动、腾讯、百度等)、电信运营商(中国移动、中国电信、中国联通)、各地方城市及央国企。

大型科技公司拥有云计算业务,需要大规模投资智能算力——也就是采购芯片和服务器,租赁土地建设数据中心。这些算力投资会在科技公司的资本支出中有所体现。

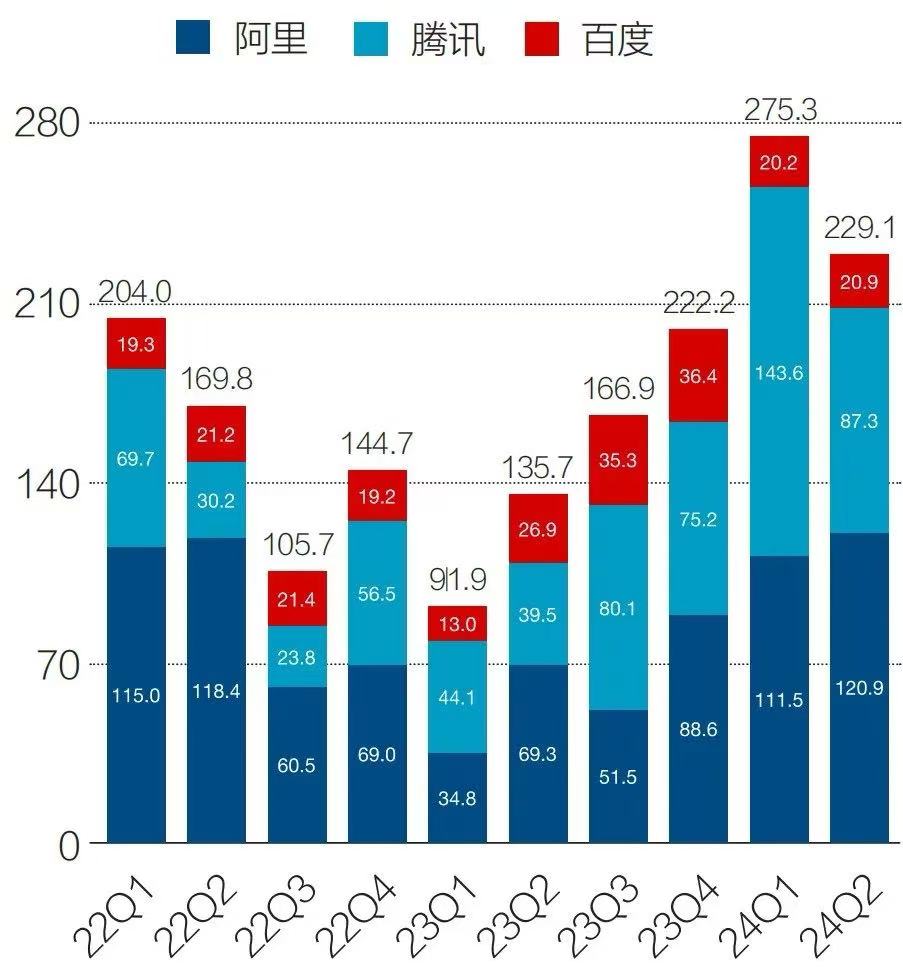

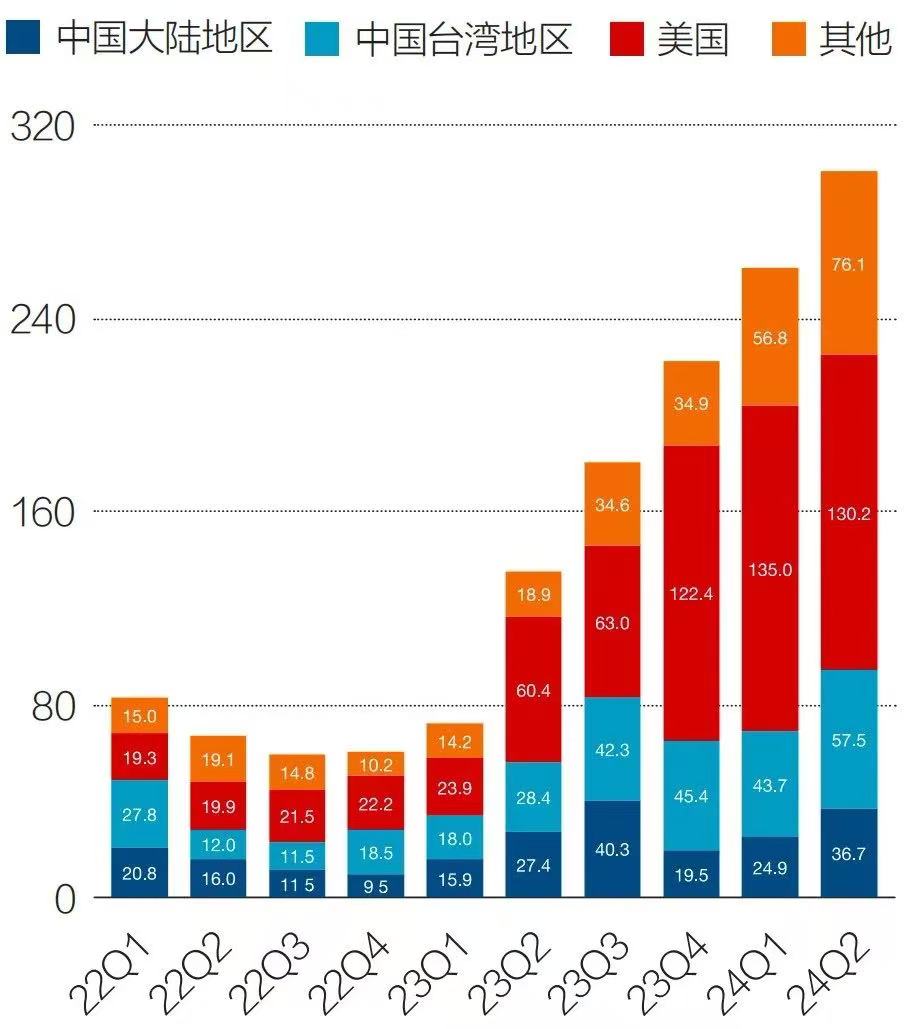

图1:阿里、腾讯、百度资本支出(2021年一季度—2024二季度)

单位:亿元 注:1.阿里自然年与财年不一致,数据已按照自然年进行调整;2.科技公司资本支出通常用于采购芯片、服务器,租赁土地建设数据中心;3.科技公司的资本支出与算力投资直接相关 资料来源|公司财报,《财经》整理 制图|于宗文

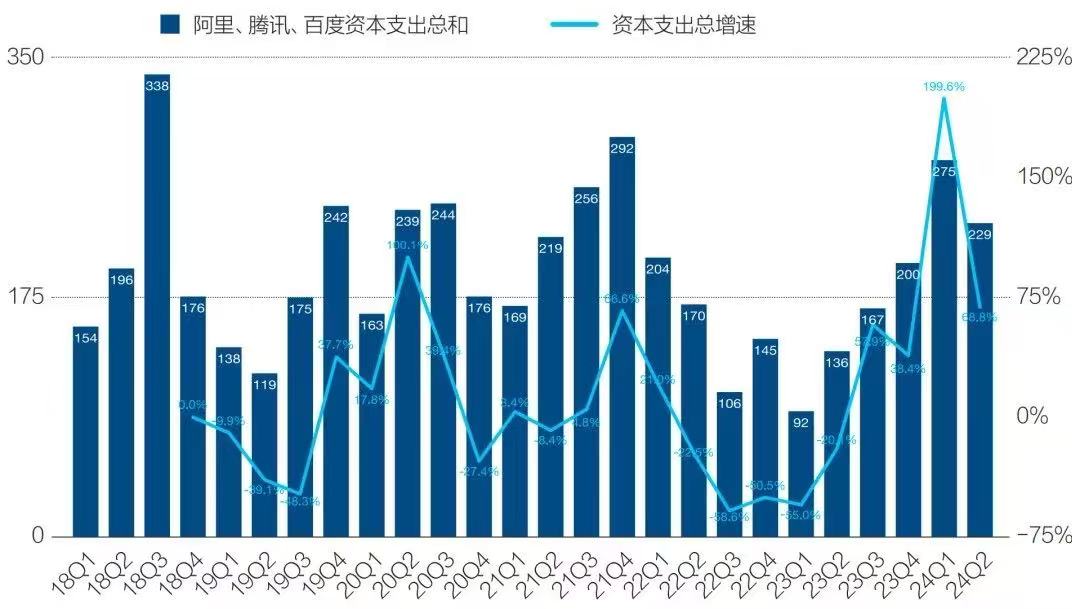

几个拥有云计算业务的科技公司资本支出都在快速增长。华为、字节跳动不是上市公司,未披露相关数据。2024年上半年,阿里、腾讯、百度的资本支出总和高达504.4亿元,同比增长121.6%。这一增速是2018年以来的最高点,且增长趋势短期不会改变。

阿里2025财年一季度(即2024年二季度)财报电话会中,管理层披露称,未来几个季度预计将继续保持高速资本支出。今年9月的云栖大会上,阿里集团CEO(首席执行官)、阿里云智能董事长兼CEO吴泳铭表达了阿里继续加码AI算力投入的决心。他直言,阿里云正在少有的高强度投入AI技术研发和基础设施建设。

如果延续上半年的增长趋势,2024年阿里、腾讯、百度资本支出总和将超过1300亿元。巨额资本支出让大型科技公司拥有了相对充足的算力储备。我们的综合调研结果显示,目前阿里、字节跳动已具备10万卡级别的算力储备。

图2:阿里、腾讯、百度资本支出总和、增速(2018年一季度-2024年二季度)

单位:亿元 注:1.阿里自然年与财年不一致,数据已按照自然年进行调整;2.科技公司资本支出通常用于采购芯片和服务器,租赁土地建设数据中心。这与算力投资直接相关 资料来源|公司财报,《财经》整理

中国电信运营商的算力投资不逊色于大型科技公司。尤其是2023年之后,电信运营商资本支出重点已从5G转向算力。

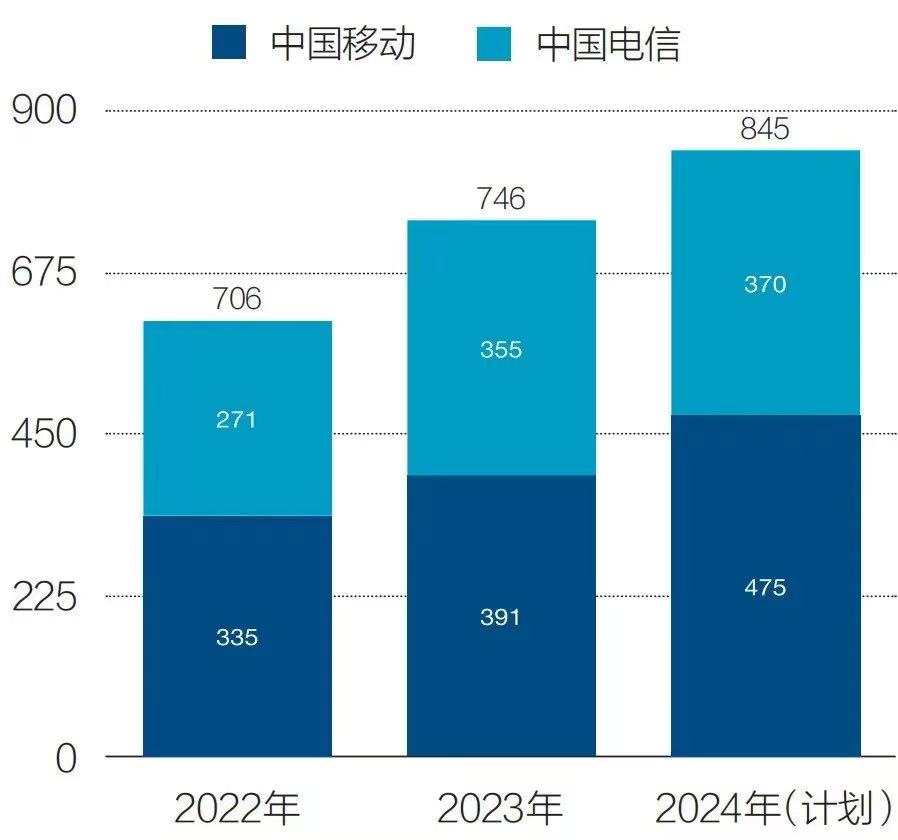

中国移动、中国电信均在2023年报中披露了2024年的算力投资计划,不过中国联通未披露算力投资情况。中国移动、中国电信2024年财报显示,两者当年算力相关投资计划分别是475亿元、370亿元。两者合计845亿元,同比增长13%。

图3:电信运营商算力相关资本支出(2022年-2024年)

单位:亿元 注:1.为统计方便,中国电信资本支出选取口径为产业数字化开支;2.中国电信的算力资本支出囊括在产业数字化开支中,未单独披露;3.中国移动、中国电信2024年的资本支出均为财报披露的计划数据 资料来源|公司财报,《财经》整理 图4:中国移动2024年两大智算公开招标案

注:1.中国移动公开招标案中披露了服务器采购台数和标包金额;2.中标方为昆仑、华鲲振宇、宝德、百信、长江、鲲泰、湘江鲲鹏、四川虹信软件等昇腾经销商 资料来源|公司财报,《财经》整理

中国移动、中国电信作为央国企,承担着国产智算采购的重要任务。尤其是中国移动,为国产智算采购付出了巨额支出。2024年中国移动公开发布的两个国产智算采购招标标案(《2024年至2025年新型智算中心采购》《2023年-2024年新型智算中心(试验网)采购(标包12)》)总金额为216亿元,总计超过9200台昇腾AI服务器。一台AI服务器通常会搭载4卡-8卡。这意味着中国移动的昇腾AI芯片公开招标采购规模至少在3.6万卡-7.4万卡之间。

今年上半年,中国移动董事长杨杰、中国电信董事长柯瑞文都曾公开表示,要建成一批万卡级智算中心。事实上,中国移动、中国电信已建成多个万卡智算中心,且以国产算力为主。中国移动官网显示,该公司已在呼和浩特、哈尔滨分别建立了万卡智算中心,呼和浩特智算中心有超过2万卡,哈尔滨智算中心有超过1.8万卡。中国电信已经在上海临港智算园区投产1.5万卡公共智能算力中心,中国电信的京津冀智能算力中心也具备超过1万卡。

各地方城市及央国企也是重要的算力投资方。其投资形式通常是,政府牵头设立专项资金,地方央国企发布招投标公告,再由第三方企业参与建设智算中心。

中国信通院一份截至今年5月的研究数据显示,中国建设和规划中的智算中心共有185座,总算力为272 (算力单位,是缩写,指每秒能执行10的18次方次浮点运算),建成运营的有104 。其中全国智算中心以云服务形式对外提供的比例是23%。

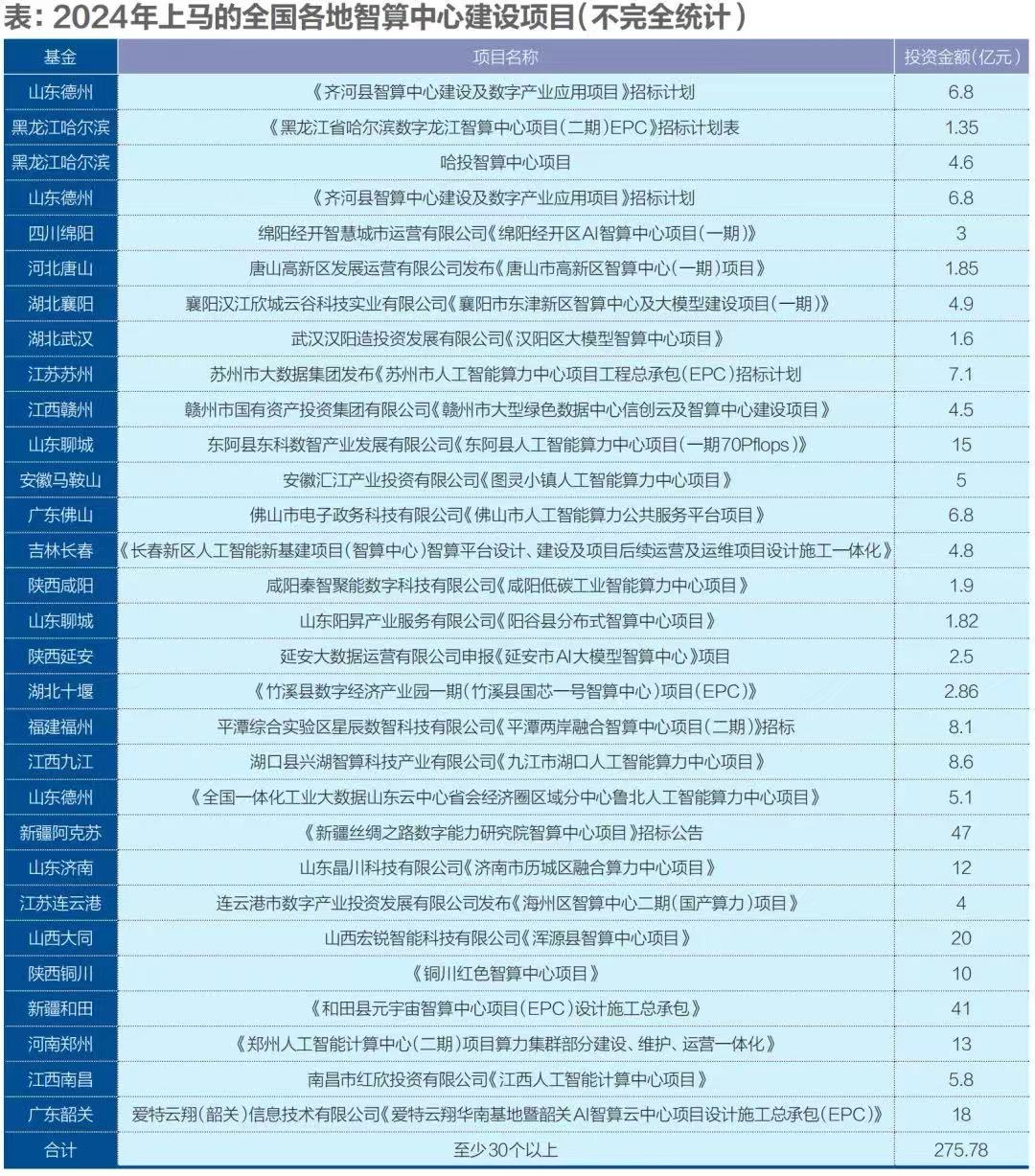

我们不完全统计发现,截至2024年10月16日,今年以来各地方城市上马的智算中心招投标项目至少在30个以上,涉及金额总和至少超过275亿元。

注:1.统计时间为2024年1月-2024年10月16日,以上为不完全统计;2.投资金额包含服务器采购、智算中心建设等软硬件及土建投入 资料来源|公司财报,《财经》整理

相比2023年,大型科技公司、电信运营商、各地方城市和央国企在2024年算力投资热度只增不减。英伟达中国市场收入也可以侧面反映这一趋势。2024年上半年英伟达在中国市场营收61.6亿美元(按美元、人民币汇率1∶7.1计算,约合437亿元人民币),比去年同期增长了42.3%。

这还是美国商务部工业安全局2023年10月出台“出口管制规则”后的结果。当时,美国向中国断供了英伟达的A100/A800、H100/H800等高性能AI芯片。为遵循管制规则,英伟达后续向中国推出了“阉割版”的H20芯片。该芯片带宽、性能均有缩水,单卡理论性能仅为H100的20%左右。

“出口管制规则”虽然存在,但英伟达并未放弃中国市场的巨大需求,而是通过合规方式向中国市场销售了更多“阉割版”AI芯片。英伟达在中国市场收入还在增长。多位供应链人士对我们表示,2024年英伟达H20系列芯片在中国市场出货量约为70万枚。

短期够用,长期短缺

算力投资不断增长。那么2024年,中国的智能算力究竟是短缺还是过剩?“短期够用,长期短缺”是主流判断。

AI芯片用途主要分成两部分:模型训练、应用推理。简单理解,前者是训练AI,后者是使用AI。它的需求结构正在变化。国际市场调研机构IDC在2023年曾预测,中国智能算力年复合增速33.9%。2022年-2027年,智能算力内部,训练算力占比会下滑到27.4%,推理算力占比将上升到72.6%。

2023年出现了算力短缺现象,成因是大模型的兴起,“百模大战”导致训练算力需求激增。美国商务部的“出口管制条例”又限制了算力供应,各个企业“恐慌式”抢购加剧了算力的供不应求。一位头部科技公司战略规划人士今年8月对我们提到,他所在企业2023年曾以高于英伟达官方定价1.5倍-2倍的价格“扫货”,抢购市面上存在的A100/A800、H100/H800芯片,其中甚至包括部分中小经销商囤积的散货。

2024年,算力逐渐够用了,各家算力越囤越多,模型训练需求却在放缓,应用推理需求尚处爆发前夜。此时出现了一个青黄不接的“空档期”。部分科技公司技术人士的判断是,这个“空档期”可能会持续到2025年上半年,但总体不会太长。

目前,阿里、字节跳动、百度等国内科技公司的旗舰模型都已接近AI创业公司旗下大模型GPT-4的性能。GPT-4系列之后的下一代模型尚未真正出现,追赶GPT-4的任务告一段落。因此,国内各大科技公司暂时放缓了模型训练的步伐。一位科技公司云厂商高管今年9月对我们表示,他所在云平台的训练算力需求增长平缓,推理算力甚至需求已超过训练算力需求。

决定“空档期”有多长的因素有两点:其一,下一代模型训练的竞赛何时开启;其二,推理算力增速有多快——这是AI应用普及渗透速度决定的。

过去两年,“堆算力”是模型性能提升的主要路径。因为大模型的性能提升遵循着 Law(AI创业公司在2020年提出的定律,直译为“缩放定律”)——模型性能主要与计算量、模型参数量和训练数据量三者大小相关。

英伟达还在为下一代模型提供更强性能的AI芯片,如B100系列。今年8月,英伟达管理层在2024年二季度财报电话会中表示,下一代基础大模型将需要10倍-20倍的计算能力来训练更多数据。

图5:英伟达全球各地区营收规模(2022年一季度-2024年二季度)

单位:美元 注:1.英伟达自然年与财年不一致,数据已按照自然年进行调整;2.为方便统计,图表中把英伟达中国大陆地区、中国台湾地区、美国以外的收入合计为“其他”;3.英伟达财报统计中的中国大陆地区的收入包含了中国香港 资料来源|公司财报,《财经》整理

今年9月,多位云厂商人士对我们表示,2023年1万枚AI芯片是训练基础大模型的入场券。2024年以后,训练下一代基础大模型有朝着10万枚AI芯片演进的趋势,但目前国际市场尚无成功案例。2025年-2026年,如果下一代基础大模型出现,国内厂商追赶它所需要的训练算力也会指数级增长。

让很多从业者做出智能算力“长期短缺”这一判断的主要原因是,随着AI应用逐渐渗透,推理算力需求逐步增长是个确定趋势。

图6:IDC中国智能算力规模及预测(2020年-2027年)

单位:(算力单位,每秒浮点运算次数) 注:1.FP64(双精度)、FP16(半精度)均为算力的计算方式;2.智能算力、通用算力的规模无法直接对比;3.2027年为预测数据 资料来源|国际市场调研机构年12月

目前,训练算力仍占据主流。训练算力和推理算力的总占比为6∶4。今年8月,英伟达管理层在2024年二季度财报电话会中表示,过去四个季度中,推理算力占英伟达数据中心收入约为40%。但在未来,推理算力的收入将持续提升。

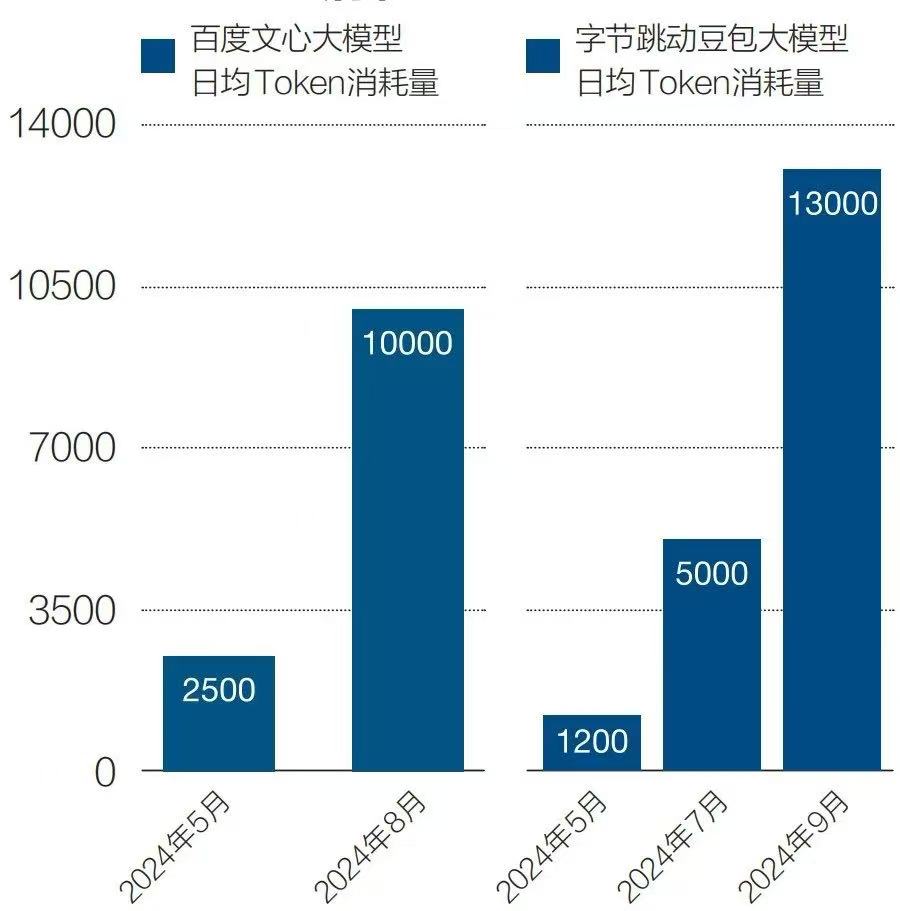

今年下半年,推理算力的爆发式增长已初见端倪。Token是AI推理算力的计量单位,就像电力用“度”计费、流量用“G”计费。一个Token可以是单词、标点、数字、符号等。百度财报披露,旗下文心大模型日均Token消耗量从今年5月的2500亿增长3倍到今年8月的1万亿。字节跳动近期公布,旗下豆包大模型日均Token消耗量从今年5月的1200亿增长10倍到了今年9月的1.3万亿。

图7:百度、字节跳动旗下大模型日均Token消耗量

单位:亿/日均 注:1.百度数据来自百度财报披露;2.字节跳动数据来自字节跳动发布会披露 资料来源|公司财报、发布会披露,《财经》整理

今年9月字节跳动火山引擎智能算法负责人吴迪对我们表示,字节跳动综合考虑算力资源储备、市场未来用量、模型成本下降等因素判断,2027年豆包每天Token消耗量会超过100万亿,将是现在的100倍以上。

随着AI应用渗透率不断提升,推理算力消耗量还会持续提升。按照IDC预测结果,2027年推理算力在智能算力大盘中的占比甚至会超过70%。

“算力长期短缺”判断的另一个潜在考量是:美国对中国的先进AI芯片出口管制短期不会取消,管制范围甚至随时可能会扩大。

一位华为人士今年9月对我们表示,英伟达H20芯片目前虽然仍对中国销售,但要做好最坏的思想准备。因为供应链随时可能会被切断。华为昇腾910系列芯片目前使用的高带宽内存(HBM)来自韩国企业SK海力士。目前,国内缺少能用好用的HBM替代品。极端情况下,如果SK海力士的HBM供应链条被切断,昇腾910的产能也会受到影响。

AI芯片是易耗品,英伟达AI芯片的折旧年限一般是三年。也就是说,囤积的AI芯片如果无法得到持续补充,迟早会有耗尽的一天。基于上述考虑,中国企业需要未雨绸缪——这也是主要的大型科技公司仍然坚持“适度超前投资”策略的核心原因。

用好闲置算力

不可忽视的情况是,中国市场部分算力供应商出现了智能算力闲置。我们了解到,电信运营商、部分地方智算中心存在闲置的算力。

有科技公司战略规划人士对我们表示,局部的算力闲置,不能等同于“算力过剩”。很多企业采取了“适度超前投资”策略,因此智能算力少量闲置是正常的。国产AI芯片的闲置情况更特殊。因为国产AI芯片目前只做到了“能用”,离“好用”还有一段距离。盲目使用只会造成算力浪费。企业需要通过各种技术手段做适配,最大程度提升国产AI芯片的使用效率。

如何用好现有的智能算力?在硬件受限的情况下,可以通过软件手段压榨出AI芯片的算力效率。使用云服务形式向社会提供算力,在训练、推理环节提高AI芯片利用率,这都可以有效提升算力效率。

中国信通院截至今年5月的研究数据显示,中国建设和规划中的智算中心共有185座,全国智算中心以云服务形式对外提供的比例是23%。我们了解到,公共云合理利用率为40%-60%,政务云合理利用率区间为25%-40%,但私有化算力资源使用率一般不超过5%。提高云服务的算力输出比例,可以有效提升智能算力使用效率。阿里云、华为云已向多个政策部门提出了这一建议。

模型训练通常由千卡、万卡集群完成。单卡故障会影响集群运作。集群越大、芯片越多,故障率就越高。百度系统架构师、百度智能云AI计算部负责人王雁鹏今年9月在一场小规模活动中提到,有效AI算力=单卡算力有效率×并行计算有效率×有效训练时间。极端情况下,模型训练会浪费50%的算力资源。他建议,企业可以在自有数据中心部署百度百舸计算平台等调度工具提高训练算力使用效率。

应用推理是未来的算力消耗大头,优化模型结构同样能节省算力。一位云厂商大模型业务核心负责人今年8月对我们表示,核心原则是在提出的 Law原则下提升数据质量、数量,适当降低模型参数,还可以采用MoE(通过混合多个专业模型,获得更好性能)架构提升模型性能、降低推理成本。这两种策略都是在保证模型效果的前提下,减少算力消耗。

走过2023年的智能算力短缺后,2024年中国智能算力正处于“短期够用,长期短缺”的状态。下一阶段,算力供需关系仍将剧变,可以采取适度超前投资、提高算力效率的策略应对市场变化。