英特尔 AI 产品面向 Meta 最新大语言模型 Llama 3.1 进行优化

为了推动“让 AI 无处不在”的愿景,英特尔在打造 AI 软件生态方面持续投入,并为行业内一系列全新 AI 模型提供针对英特尔 AI 硬件的软件优化。今日,英特尔宣布公司横跨数据中心、边缘以及客户端 AI 产品已面向 Meta 最新推出的大语言模型(LLM)Llama 3.1 进行优化,并公布了一系列性能数据。

继今年 4 月推出 Llama 3 之后,Meta 于 7 月 24 日正式发布了其功能更强大的 AI 大模型 Llama 3.1。Llama 3.1 涵盖多个不同规模及功能的全新模型,其中包括目前可获取的、最大的开放基础模型 —— Llama 3.1 405B(4050 亿参数)。目前,英特尔丰富的 AI 产品组合已支持上述最新模型,并通过开放生态系统软件实现针对性优化,涵盖 及英特尔 扩展包(Intel for )、、 Face 库和 vLLM 等。此外,企业 AI 开放平台(OPEA)亦为这些模型提供支持,OPEA 这一全新的开放平台项目是由 LF AI & Data 基金会发起,旨在聚合生态之力,推动创新,构建开放、多供应商的、强大且可组合的生成式 AI 解决方案。

Llama 3.1 多语言大模型组合包含了 80 亿参数、700 亿参数以及 4050 亿参数(文本输入 / 文本输出)预训练及指令调整的生成式 AI 模型。其每个模型均支持 128k 长文本和八种不同的语言。其中,4050 亿参数的 Llama 3.1 模型在基本常识、可操作性、数学、工具使用和多语言翻译方面具有行业领先的能力。同时,该模型亦帮助开发者社区解锁诸如合成数据生成和模型蒸馏(Model )等全新功能。

以下内容展示了英特尔的部分 AI 产品组合运行 Llama 3.1 模型的初步性能结果,包括英特尔 至强 处理器、搭载英特尔 酷睿 Ultra 处理器和英特尔锐炫 显卡的 AI PC 产品。

运行 Llama 3.1 时展现出卓越性能

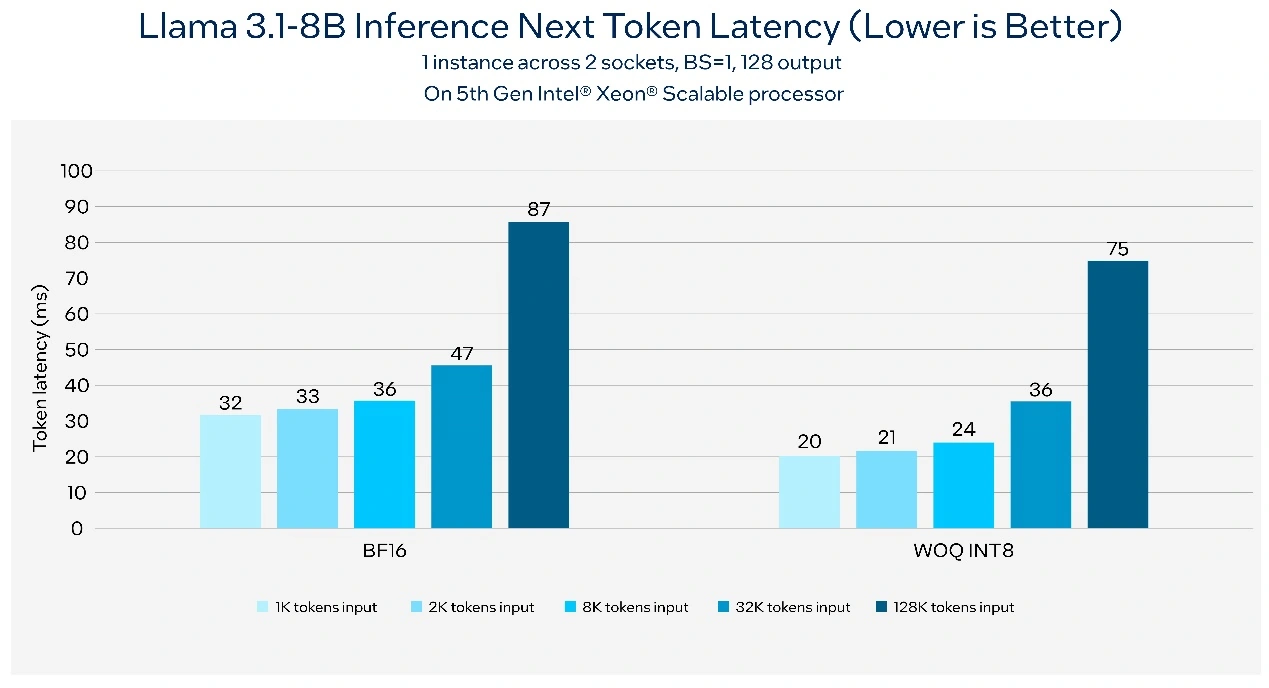

作为通用计算的基石,英特尔 至强 处理器为全球用户提供强大算力,现已通过各大云服务商面市。英特尔至强处理器在其每个核心中均内置了英特尔 高级矩阵扩展(AMX)AI 引擎,可将 AI 性能提升至新水平。根据基准测试,在第五代英特尔至强平台上以 1K token 输入和 128 token 输出运行 80 亿参数的 Llama 3.1 模型,可以达到每秒 176 token 的吞吐量,同时保持下一个 token 延迟小于 50 毫秒。图 1 展示了运行支持 128k 长文本的 80 亿参数 Llama 3.1 模型时,下一个 token 延迟可低于 100 毫秒。

图 1. 基于第五代英特尔 至强 可扩展处理器的 Llama 3.1 推理延迟

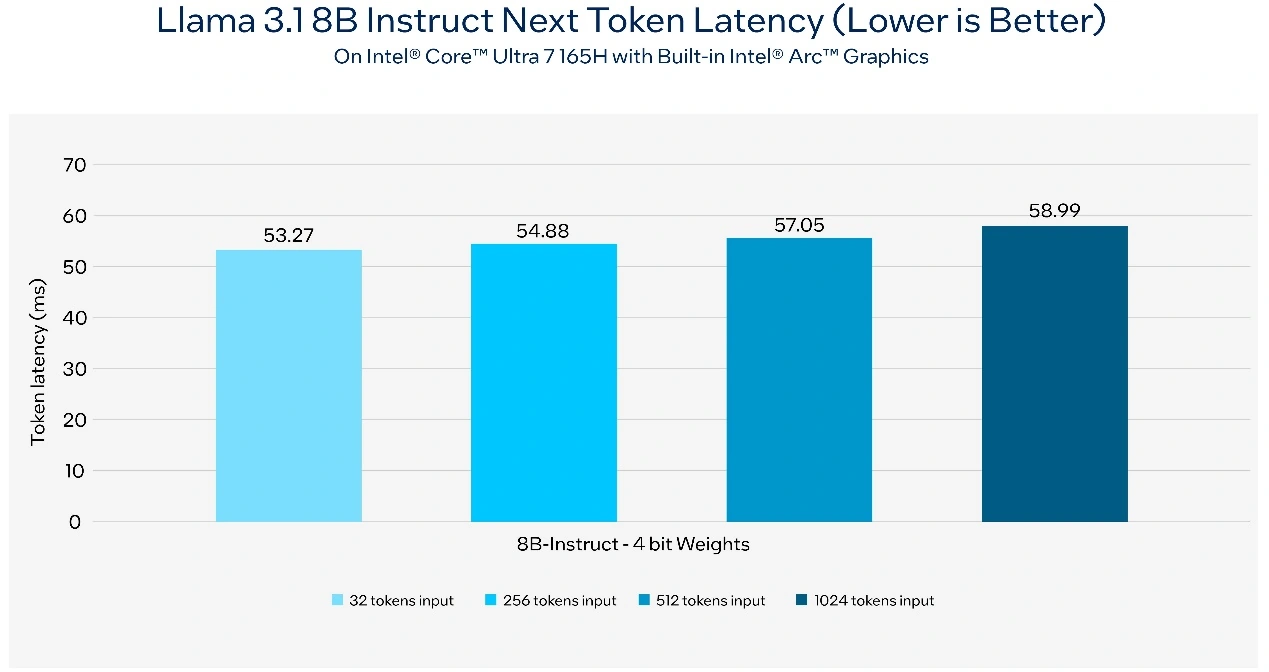

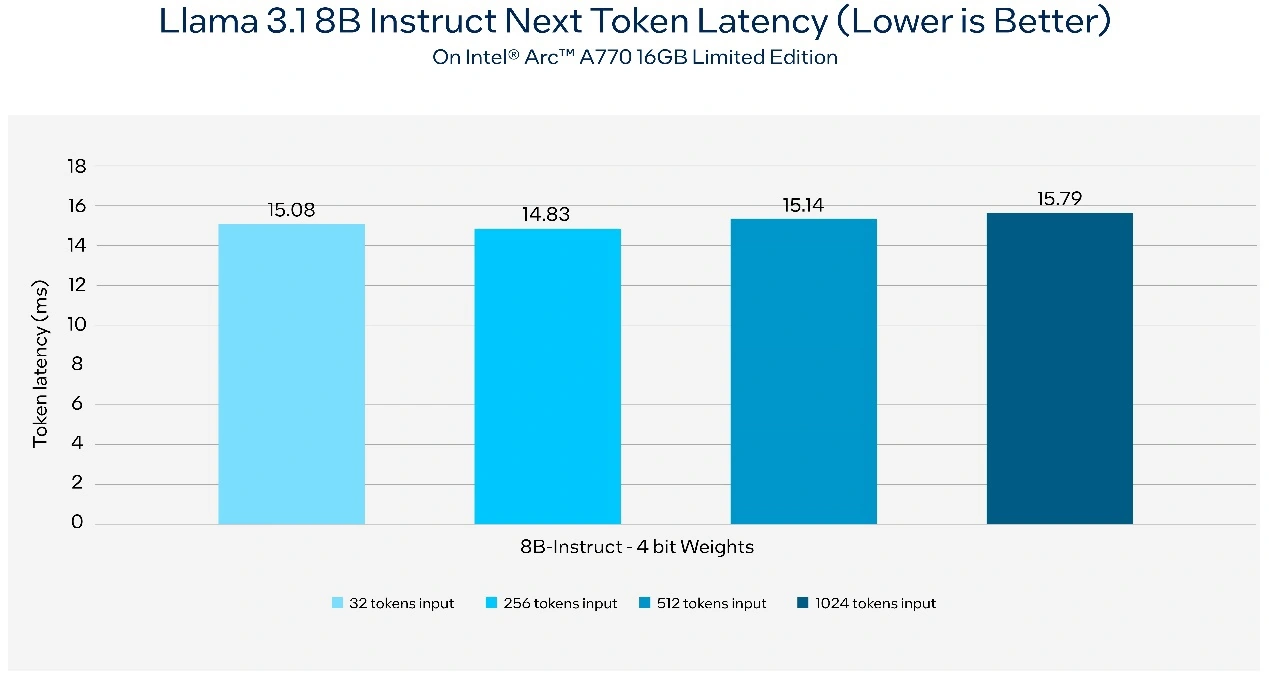

由英特尔 酷睿 Ultra 处理器和英特尔锐炫 显卡驱动的 AI PC 可为客户端和边缘提供卓越的设备端 AI 推理能力。凭借诸如英特尔酷睿平台上的 NPU,以及锐炫显卡上英特尔 Xe 加速等专用的 AI 硬件,在 AI PC 上进行轻量级微调和应用定制比以往更加容易。对于本地研发, 及英特尔 扩展包等开放生态系统框架可帮助加速。而对于应用部署,用户则可使用英特尔 工具包在 AI PC 上进行高效的模型部署和推理。AI 工作负载可无缝部署于 CPU、GPU 以及 NPU 上,同时实现性能优化。

图 2. 在配备内置英特尔锐炫 显卡的英特尔 酷睿 Ultra 7 165H AI PC 上,Llama 3.1 推理的下一个 token 延迟

图 3. 在使用英特尔锐炫 A770 16GB 限量版显卡的 AI PC 上,Llama 3.1 推理的下一个 token 延迟

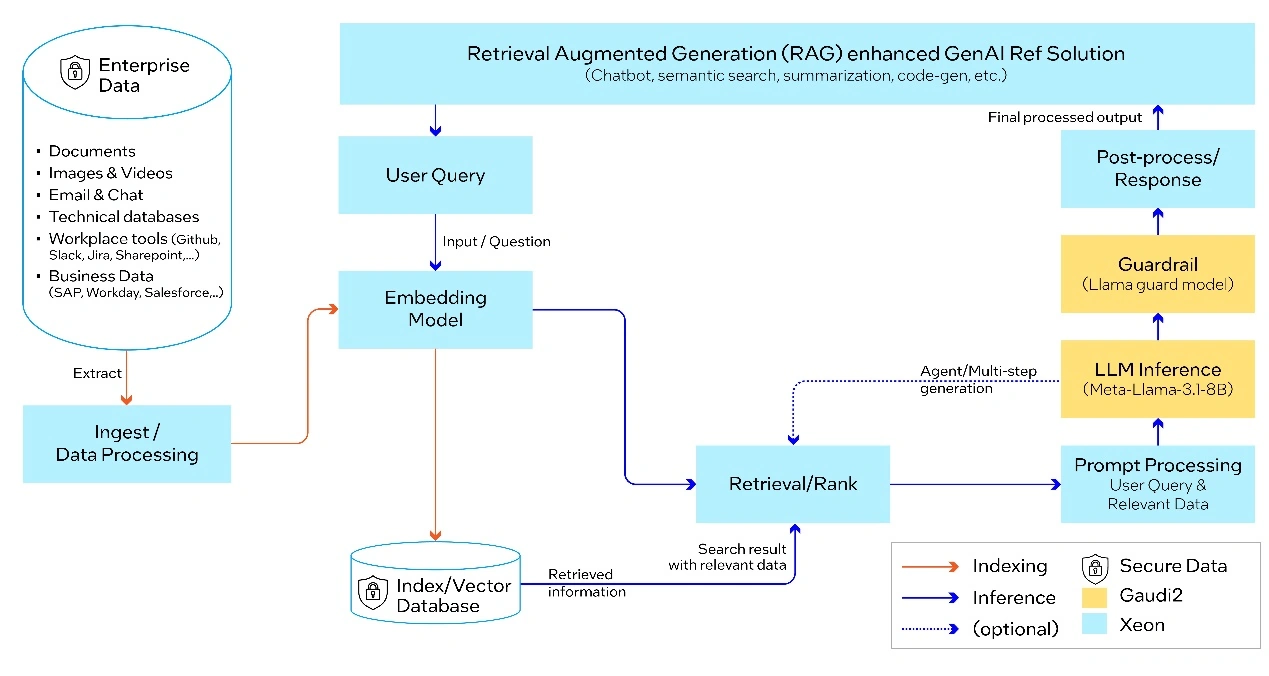

利用 Llama 3.1 和 OPEA 部署企业 RAG 解决方案

英特尔 AI 平台和解决方案能够有助于企业部署 AI RAG。作为 OPEA 的发起成员之一,英特尔正帮助引领行业为企业 AI 打造开放的生态系统,同时,OPEA 亦助力 Llama 3.1 模型实现性能优化。

基于可组合且可配置的多方合作组件,OPEA 为企业提供开源、标准化、模块化以及异构的 RAG 流水线()。此次测试中,微服务部署于 OPEA 蓝图的每一支细分领域中,包括防护()、嵌入()、大模型、数据提取及检索。端到端 RAG 流水线通过 Llama 3.1 进行大模型的推理及防护,使用 BAAI / bge-base-en-v1.5 模型进行嵌入,基于 Redis 向量数据库,并通过 (K8s)系统进行编排。

图 4:基于 Llama 3.1 的端到端 RAG 流水线,由英特尔 Gaudi 2 加速器和至强处理器提供支持

目前,英特尔 AI PC 及数据中心 AI 产品组合和解决方案已面向全新 Llama 3.1 模型实现优化,OPEA 亦在基于英特尔至强等产品上全面启用。未来,英特尔将持续投入软件优化,支持更多全新的模型与用例。

产品与性能信息

英特尔至强处理器:在第五代英特尔 至强 可扩展处理器上测量,使用:2 个英特尔至强 8593Q、64 核、超线程开启、睿频开启、NUMA 4、512GB( DDR5 5600 MT/s [5600 MT/s])、BIOS 3B07.、微码 、三星 SSD 970 EVO Plus 2TB、 9、5.14.0-437.el9.、使用 和 IPEX 2.4 运行的模型。英特尔于 2024 年 7 月 22 日进行测试。点击获取资源库。

英特尔 酷睿 Ultra:在搭载英特尔酷睿 Ultra 7 165H 平台的微软 6 上进行测量,使用 32GB 总内存、英特尔显卡驱动程序 101.5762、IPEX-LLM 2.1.、 11 Pro 版本 22631.3593、性能电源策略与核心隔离启用。英特尔锐炫 显卡仅适用于部分 H 系列英特尔 酷睿 Ultra 处理器驱动的系统,且双通道配置中系统内存至少为 16GB。需要 OEM 支持,请咨询 OEM 或零售商了解系统配置详情。英特尔于 2024 年 7 月 18 日进行测试。点击获取资源库。

英特尔锐炫 A 系列显卡:使用英特尔酷睿 i9-、华硕 ROG Z790 HERO 主板、32GB (2x 16GB) DDR5 和 MP600 Pro XT 4TB NVMe SSD,对英特尔锐炫 A770 16GB 限量版显卡进行测量。软件配置包括英特尔显卡驱动程序 101.5762、IPEX-LLM 2.1.、 11 Pro 版本 22631.3593、性能电源策略与核心隔离禁用。英特尔于 2024 年 7 月 18 日进行测试。