AI服务器网络组件的痛点:烟囱式结构与网络瓶颈解析

所有这些网络技术往往依赖于专用的网络接口卡(NIC)和交换机。当前,AI服务器的网络组件如NICs、PCIe交换机和Rail ,大都像“烟囱式”()结构一样单独存在(如下图所示),彼此之间缺乏统一协调,网络带宽不足,缺乏可靠的容错机制,难以应对AI训练和推理过程中庞大的数据流量。

图源:

这样的结构特点还带来了诸多痛点:如在GPU之间传输数据时容易产生拥堵,数据在网络中需要经过多个设备跳转,增加了延迟;网络负载分布不均,可能导致“入汇拥塞”(),即大量数据同时到达某一点时引发的瓶颈;此外,碎片化和低效率的网络设计导致AI集群的总成本(TCO)显著增加,因为存在GPU和计算资源闲置的情况,造成资源浪费与带宽利用率低,GPU间的链路如果发生故障,会导致整个任务停滞,影响系统的可靠性和稳定性。

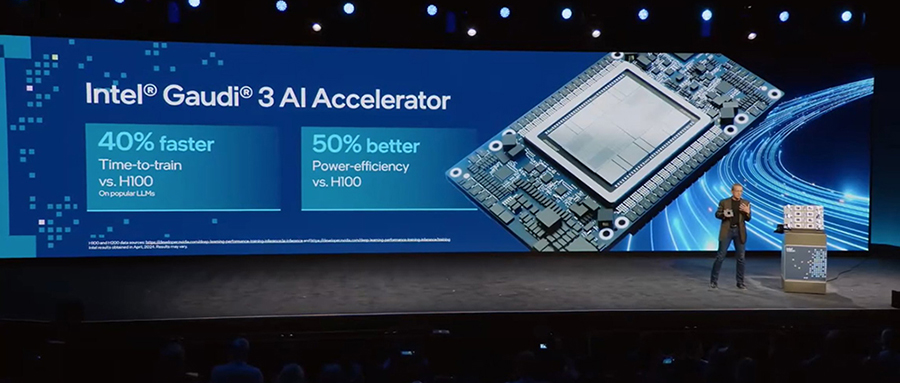

行业变革日新月异,现在GPU已经取代CPU成为AI数据中心的核心处理资源,GPU和加速器计算基础设施的资本支出在全球所有顶级云提供商中占据传统计算支出的主导地位——这一切都归功于生成式AI的市场潜力。但值得注意的是,目前部署在这些系统中的网络芯片,包括连接加速计算的PCIe交换机、NIC网络接口控制器和机架顶交换机,依然是为传统x86计算架构时代设计的产品。这些设备上I/O带宽的滞后已经成为AI扩展的瓶颈。

网络芯片,也需要与时俱进了。本文我们所描述的公司,他们开发的ACF-S技术有望在这一领域占据一席之地。

取代多种网络芯片,ACF-S芯片要“革互连的命”

的ACF-S是一种服务器结构芯片,它不使用行业标准的PCIe交换机和具有RDMA的以太网网络接口卡(NIC),而是将CXL/PCIe交换功能和RNIC(远程网络接口卡)功能集成到单一设备中,也就是不再需要PCIe、NIC(网络接口控制器)或独立的CPU连接DRAM,而且这种方法消除了对CXL高级功能的依赖。这种架构和思路与超级以太网(UEC)白皮书所倡导的所有方面都需要加速器、NIC和交换机结构之间的协调不谋而合。

图源:

首席执行官 表示:“这不是CXL架构,不是以太网交换机,也不是DPU——它可以做所有这些事情。这是一类不同的产品,可以解决不同类别的问题。”

据了解,的ACF-S采用100%基于标准的硬件和软件接口,包括原生多端口800千兆以太网网络和高基数PCIe Gen5和CXL 2.0+接口。该结构可直接桥接和互连GPU、CPU、加速器、内存和网络等各种设备,在这些设备之间提供可扩展、流式、每秒多TB的数据传输。它将消除对专用网络互连和传统机架顶部通信硬件的需求,充当通用数据移动器,克服现有数据中心的I/O限制。

也就是说,ACF-S无需改变设备驱动程序之上的物理接口、协议或软件层,即可在单个硅片中实现异构计算和内存资源之间的多TB交换和桥接,同时大幅减少当今AI集群中由机架顶部网络交换机、RDMA-over- NIC、 HCA、PCIe/CXL交换机和连接CPU的DRAM所消耗的设备数量、I/O延迟跳跃和设备功率。

通过结合独特的CXL内存桥接功能,的ACF-S成为业内首款可为任何加速器提供无头内存扩展的数据中心硅产品,使单个GPU机架能够直接、低延迟、无争用地访问本地CXL DDR5 DRAM,其内存容量是GPU原生高带宽内存(HBM)的50倍以上。

成本也是这家初创公司的卖点之一。这是由于节省了购买NIC和PCIe交换机的费用。据该公司称,的旗舰ACF交换机硅片使客户能够在相同性能点上将大型语言模型(LLM)推理的GPU计算成本降低约50%,将深度学习推荐模型(DLRM)推理的GPU计算成本降低75%。

3.2Tbps超高速,实现50多万GPU互连

2024年11月19日,在超级计算2024(SC24)大会上,宣布其突破性的3.2太比特/秒(Tbps)ACF 芯片“”及其相应的试点系统全面上市。为GPU服务器提供多端口800千兆以太网连接,带宽和多路径弹性是业内任何其他GPU连接网络接口控制器(NIC)产品的四倍。芯片将于2025年第一季度开始批量供货。

图源:

具有高基数、高带宽和并发PCIe/以太网多路径和数据移动功能,可以独特地在每个服务器系统中纵向和横向扩展四到八个最新一代GPU,为AI集群带来前所未有的性能、规模和弹性。还引入了软件定义的RDMA网络,将传输堆栈控制权交给数据中心运营商,而不是NIC供应商的固件,而不会影响线速网络性能。

凭借单个ACF-S芯片上的800、400和100千兆以太网接口以及32个网络端口和160个PCIe通道的高基数,首次可以使用更高效的两层网络设计构建超过50万个GPU的AI集群,从而实现集群中所有GPU的最高横向扩展吞吐量和最低的端到端延迟。

2层500K+GPU集群设计(跨所有网络层的完整横截面带宽)(图源:)

相信其互联技术将成为未来GPU计算网络的核心。 Inc.副总裁兼首席分析师Andy 表示,可以为AI网络领域提供一个有趣的替代方案,目前该领域由及其解决方案主导。他解释说,的一个显着差异是它能够在GPU和CPU之间高速移动数据。

也就说,不仅是GPU,还有望改变CPU的竞争力。表示:“这可以让更多公司探索使用CPU而不是GPU来开发人工智能,因为GPU目前供应不足。的独特优势在于它使用现有的接口、协议和软件堆栈,因此无需重新连接基础设施。”

结语

随着AI模型训练对效率和成本效益的要求不断提高,网络的重要性愈发凸显。据650 Group预测,到2027年,数据中心在计算、存储和网络芯片高性能I/O领域的硅片支出将翻倍,超过200亿美元。这无疑是一块极具吸引力的市场蛋糕。

英伟达等公司对初创公司的投资,不仅彰显了对其技术创新的高度认可,更是着眼于未来AI生态战略布局的一步棋。要突破当前人工智能领域面临的网络I/O瓶颈,离不开应用人工智能、GPU计算和高性能网络领域的专家之间的创造性工程设计和紧密协作。只有摒弃孤立竞争,形成合力,才能共同推动技术进步,为行业注入新动力。