谷歌出售数据中心领域最大芯片设计公司,超越微软亚马逊

尽管谷歌是一家无晶圆厂设计公司,不向第三方公司出售芯片,但它是数据中心处理器业务中真正的巨头。山景城公司拥有重要的市场份额,由于最近人工智能的爆炸式增长,该市场份额有望进一步扩大。

Tech 发布的新研究将谷歌评为数据中心领域最大的芯片设计公司之一。Tech 表示,凭借其在半导体供应链和 ASIC 市场等多个领域的独特专业知识,谷歌的市场份额可与英特尔和 AMD 等更知名的芯片制造商相媲美。

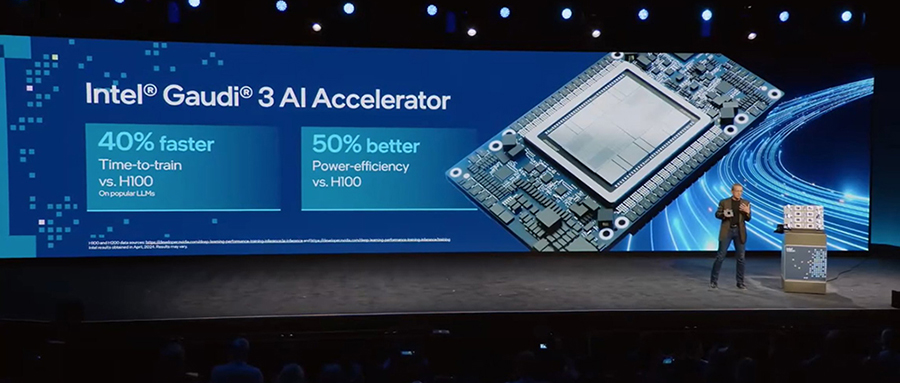

Tech 强调,谷歌在 2015 年推出的张量处理单元 ( TPU ) 开创了定制人工智能加速器的先河,这使得该公司超越了云竞争对手微软和亚马逊。就市场份额而言,只有英伟达和英特尔超越谷歌。

Tech 指出,谷歌去年向其全球数据中心运送了 200 万个 TPU。随着 TPU v4 的推出,该业务在 2021 年实现了显着增长,恰逢大型语言模型的兴起。 是 在 ASIC 设计方面的主要合作伙伴,它可能从 TPU v4 的推出中受益最多。

谷歌使用 TPU 来加速内部工作负载,而 GPU 则处理云计算任务。Tech 报告称,到 2023 年,谷歌将拥有最大的 AI 加速器安装基数和最大的 AI 计算基础设施。该公司最近推出了第六代 TPU,称为,旨在增强 AI 超级计算机架构。

TI 还指出,随着云超大规模企业投资新的加速器和 AI GPU,去年服务器市场的库存出现了重大调整。微软和亚马逊还分别使用 Azure 和 开发定制人工智能加速器。

Azure 和 都是基于 Arm 的定制处理器。谷歌最近推出了基于 Arm 的 Axion 处理器来补充其 TPU。根据 的报告,Arm 架构目前已用于全球 10% 的服务器,其中超过 50% 安装在亚马逊的 AWS 数据中心。

谷歌的第六代TPU

5 月 14 日星期二,谷歌发布了名为 的第六代 TPU(张量处理单元)。

该芯片本质上是 TPU v6,是该公司在与 GPU 制造商英伟达以及云提供商微软和亚马逊(拥有自己的人工智能芯片)的人工智能战斗中的最新武器。

TPU v6 将继承 TPUv5 芯片,TPUv5 芯片有两种版本: 和 。该公司表示, 芯片是“迄今为止性能最高、最节能的 TPU” 。“

谷歌在加州山景城举行的 IO 会议上表示, 芯片将运行的人工智能模型将取代当前的 大语言模型。

谷歌对该芯片进行了全方位的改进。该芯片的峰值计算性能提高了 4.7 倍。它还使高带宽内存、内部带宽和芯片间互连速度加倍。

谷歌发言人在给 的电子邮件中表示:“通过比较 TPU 与 Cloud TPU v5e 的每芯片峰值计算性能 (bf16),我们得到了 4.7 倍的数字。”

BF16 在 TPU v5e 上的性能为 197 ,如果提高 4.7 倍,BF16 在 上的峰值性能将达到 925.9 。

的 TPU 早就应该有大幅的性能提升了。TPU v5e 的 197 万亿次浮点 BF16 性能实际上比 TPU v4 的 275 万亿次浮点有所下降。

芯片具有下一代 HBM 内存,但没有具体说明它是 HBM3 还是 HBM3e, 在其 H200 和 GPU 中使用了 HBM3e。

TPU v5e 上的 HBM2 容量为 16GB,因此 将拥有 32GB 的容量,HBM3 和 HBM3e 均有提供。HBM3e 提供最大的带宽。

服务器 Pod 中最多可配对 256 个 芯片,与 TPU v5e 相比,芯片间通信提高了一倍。谷歌没有透露芯片间通信速度,但 可能是 3,200 Gbps,是 TPU v5e 1,600 Gbps 的两倍。

谷歌在一篇博客文章中表示, TPU 的节能效果也比 TPU v5e 高出 67%。

正在取代 TPU 品牌名称,并将成为未来几代芯片背后的品牌。 是根据花的名字命名的,不要与 AWS 的 混淆, 是一种人工智能训练芯片。

谷歌很快就发布了其第六代 TPU——距离该公司发布 TPU v5 芯片还不到一年。

TPU v4 于 2020 年推出 ,拖了 三年才发布 TPU v5。TPU v5 本身的开发也陷入了争议之中。

谷歌声称,人工智能代理帮助 TPU v5 芯片进行平面规划,速度比人类专家快约六个小时。

与 TPU v5 AI 设计项目相关的研究人员被解雇或离职,这些说法目前正在接受《自然》杂志的调查。

服务器 Pod 将托管 256 个 芯片, AI 芯片的通信速度是类似 TPU v5 Pod 设置的两倍。

这些Pod可以组合成更大的集群, 并通过光纤网络 进行通信。舱体之间的通信速度 也将提高两倍,从而提供更大的 AI 模型所需的可扩展 性 。

谷歌表示:“ TPU 可以扩展到数百个 Pod,通过每秒数拍比特的数据中心网络互连建筑级超级计算机中的数万个芯片。”

一项名为 的技术将大型 AI 工作负载串联到大型集群中的数千个 TPU 上。这确保了 TPU 的高正常运行时间和能效。

该芯片具有第三代 ,这是一种更接近高带宽内存的中间芯片, 大多数 AI 运算都在这里进行。

使处理更接近内存中的数据, 支持 AMD、英特尔和高通正在研究的新兴计算架构。

通常,数据必须从内存移动到处理单元,这会消耗带宽并产生阻塞点。稀疏计算模型试图通过将处理单元移近内存集群来释放网络带宽。

谷歌表示:“ TPU 可以更快地训练下一波基础模型,并以更少的延迟和更低的成本为这些模型提供服务。”

还具有用于矩阵数学的 。 芯片是为人工智能设计的,不会运行科学应用程序。

该公司最近发布了首款 CPU Axion,它将与 搭配使用。

芯片将成为谷歌自主研发的 AI 超级计算机设计的一部分,该设计针对其 TPU 进行了优化。

该设计融合了计算、网络、存储和软件,以满足不同的 AI 消费和调度模型。“日历”系统满足任务何时开始的严格期限,而“弹性启动”模型则保证任务何时结束并交付结果。

超级计算机包含一个软件堆栈和其他工具,用于开发、优化、部署和编排用于推理和训练的 AI 模型。其中 包括 JAX、/XLA 和 。

超级计算机将继续使用针对 GPU 优化的互连技术,例如基于 H100 GPU 的 卸载系统和技术。

预计 芯片将在 Cloud 中提供,但谷歌没有提供提供日期。它将成为顶级产品,成本高于 TPU v5 产品。

云中 GPU 的高价格可能会让 对客户有吸引力。已经使用 ( Cloud 中的 AI 平台)中提供的 AI 模型的客户也可能会转向 。

AWS 的 芯片也可用,而微软的 Azure Maia 芯片主要用于推理。

谷歌一直将其 TPU 作为 GPU 的 AI 替代品。谷歌发布了研究论文,将 TPU 的性能与同类 GPU 进行了比较。

谷歌最近宣布将搭载 的新 GPU、B200 和带有 GPU 的专用 DGX 盒。

最近还宣布将以 7 亿美元收购 Run.ai。收购 Run.ai 将使 在运行 AI 模型时能够使其软件堆栈独立于 的堆栈。

TPU 最初是为谷歌的本土模型设计的,但该公司正在努力 更好地 映射到开源模型,其中包括 的分支 Gemma。