从“卷”训练到“重”推理,企业部署大模型的“芯”要求

在消费者对ChatGPT等消费级AI应用进行尝鲜和玩票之后,企业也迎来了AI发展的转折点。相比2023年企业纷纷训练自己的大模型,2024年企业对大模型的关注转向推理,以实现差异化和变现。一方面,企业部署大模型对计算架构带来了新的挑战;另一方面,企业对推理的重视,也使其对算力架构的选择走向多元。

“随着越来越多的通用大模型被训练出来,今年企业的关注点转向了推理。”英特尔公司市场营销集团副总裁、中国区数据中心销售总经理庄秉翰向《中国电子报》表示,“我们看到一些客户愿意尝试用CPU做大模型推理,还有一些互联网公司,之前更多提供的是基于GPU的大模型服务,现在也提供基于CPU的大模型,尤其是在推理上。”

企业迎来大模型部署浪潮 数据与模型结合成最大挑战

企业级场景,正在成为AI大模型的蓝海市场。市调机构数据显示,预计2026年80%的企业会使用生成式人工智能,至少50%的企业会在边缘计算部署机器学习或者深度学习,从而提升企业竞争力。在企业支出方面,预计企业在生成式人工智能的投资将在今年达到400亿美元规模,到2027年达到1510亿美元规模。

庄秉翰指出,企业AI的发展可以分为三个阶段。一是AI辅助阶段,AI作为企业的辅助工具,提供会议纪要总结、大纲提炼、文生图等辅助功能。二是AI助手阶段,AI赋能各领域的工作流程自动化,提供行程管理等助手型功能,以及面向客户的智能客服功能。三是全功能AI阶段,AI提供全方位、更精准的自动化服务,为企业经营带来更大价值。

无论是AI助手阶段还是全功能AI阶段,最大的挑战都在于企业数据与通用模型的结合。

“企业对自己的数据,比如传统的数据如何保存使用,哪些数据应该在公有云或者私有云使用,有很明确的规定。但是,现有AI模型大多是通用模型,一旦企业把数据上传到这些AI模型再做提炼升华,就存在数据泄漏的风险,也会对企业的竞争力带来影响。所以我们提出企业AI的概念,其核心在于以更加开放、更具规模性、更加可靠的方式,帮助企业释放AI潜力。”庄秉翰向记者表示。

按照技术架构,企业AI能力的构建可以分为四个层次。一是兼具可获取性和隐私性的底层算力。二是具备可扩展性和标准化的基础设施。比如企业在私有云部署AI,可能采用单节点、多节点或者平均式的部署,或者根据企业的发展规划从单节点小集群逐步走向更大的集群,这就需要算力基础设施具备可扩展性和标准化。三是安全可靠的软件生态。四是便捷开放的应用生态。

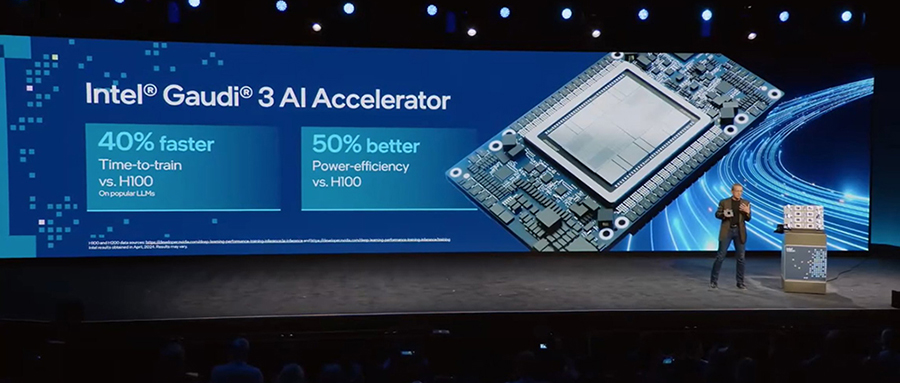

面向企业AI的部署需求,英特尔搭建了算力、基础设施、软件、应用四层生态的开放生态堆栈。其中算力生态包含基于酷睿处理器、vPRO商用PC芯片平台的AI PC,基于至强处理器、Gaudi AI加速芯片、ARC显卡的边缘AI与数据中心AI。基础设施生态包含OEM、ODM、CSP(云端服务供应商)、OSV(操作系统集成商)等。

比如在英特尔与金山云的合作中,金山云在云服务器 X7 中引入了第四代至强可扩展处理器,并基于英特尔AMX原生加速能力发布了StableDiffusion、LLaMa2、ChatGLM2三款针对X7服务器调优的大模型镜像。相较优化之前的模型,基于AMX优化的文生图大模型 Stable Diffusion推理性能提升了4.96倍,Llama2 和 ChatGLM2优化后的推理性能也分别提升了2.62倍和2.52倍。

英特尔公司市场营销集团副总裁、中国区云与行业解决方案部总经理梁雅莉表示,英特尔与金山云合作的云服务器对客户的吸引力来自三个方面。一是便捷的部署,即用户无需部署专用的AI推理服务器,而是可以在通用云服务器的基础上,通过调优的大模型镜像,快速、灵活地实现模型推理;二是成本优化;三是除了大模型推理之外,用户还可以调度金山云云服务器运行其它工作负载,实现敏捷切换。

“企业在面对不同选择之时,会考虑几点。第一是‘可及’,即该算力是能够购买、能够获取,且是通用的;二是对性能的追求;三是在易部署的情况下,能够拥有可靠的保障。”梁雅莉说。

从注重训练走向注重推理 CPU成为AI推理选项

2023年,AI大模型迎来“百模大战”的盛况。但在大模型走向落地期的过程中,企业越来越注重大模型的投入产出比和后续的盈利能力,这一点也反应在企业对底层算力架构的选择上。

庄秉翰在接受《中国电子报》专访时表示,2023年,企业对大模型的关注聚焦在训练,更注重性能,对成本和功耗没有那么重视。由于企业都希望训练自己的通用大模型,也出现了“百模大战”的现象。

随着越来越多的通用大模型被训练出来,今年企业的关注点转向了推理。对于企业来说,大模型是需要变现且能够盈利的,但目前市场上的大模型大多基于开源,用做训练的数据也差不多,很难通过差异化来盈利。而企业AI能够让企业将自身数据融合在大模型的训练过程中,使大模型真正帮助企业解决业务上的问题,增强产品竞争力。

而企业对于大模型盈利能力的重视,也体现在对底层算力架构的选择上。庄秉翰表示,推理基于大规模的算力部署,需要对智算中心的成本、功耗以及整体的运营运维进行考量。在这种趋势下,一些企业正在尝试用CPU做大模型推理。从许多案例可以看到,CPU可以支持130亿参数规模以下大模型的推理。

“对一些企业来说,大模型部署处在初始阶段。如果立即部署一个很大的GPU集群,对于运维和开发来说都是很大的挑战。如果采用逐步部署生成式人工智能的节奏,就可以通过CPU先来做一些大模型的应用部署。当不需要生成式大模型时,还可以转换到通用的应用,这也是一种可以实现盈利的方式。我们看到一些客户愿意尝试用CPU做大模型推理,还有一些互联网公司,之前更多提供的是基于GPU的大模型服务,现在也提供基于CPU的大模型,尤其是在推理上。”庄秉翰向《中国电子报》记者表示。

而算力架构的选择,也与企业类型和所处阶段息息相关。梁雅莉表示,企业要因地制宜,选择最适合企业的人工智能策略,并基于该策略选择最适合的基础设施和架构。

“对于头部互联网和大模型公司来讲,今年面临的挑战是大模型的落地和变现。对于其他企业来说,如何挑选合适的大模型融入生产或业务流程以创造价值,是更重要的命题。”梁雅莉向《中国电子报》记者表示,“当大模型和生成式人工智能热度褪去,需要变现并产生价值的时候,就需要思考落地的经济适用性和最适合的方案。”